Итак, мы установили ESXi, развернули виртуальную машину с Vcenter(VCSA 6.5), произвели его первоначальную настройку. Давайте теперь настроим сеть на нашем хосте ESXi.

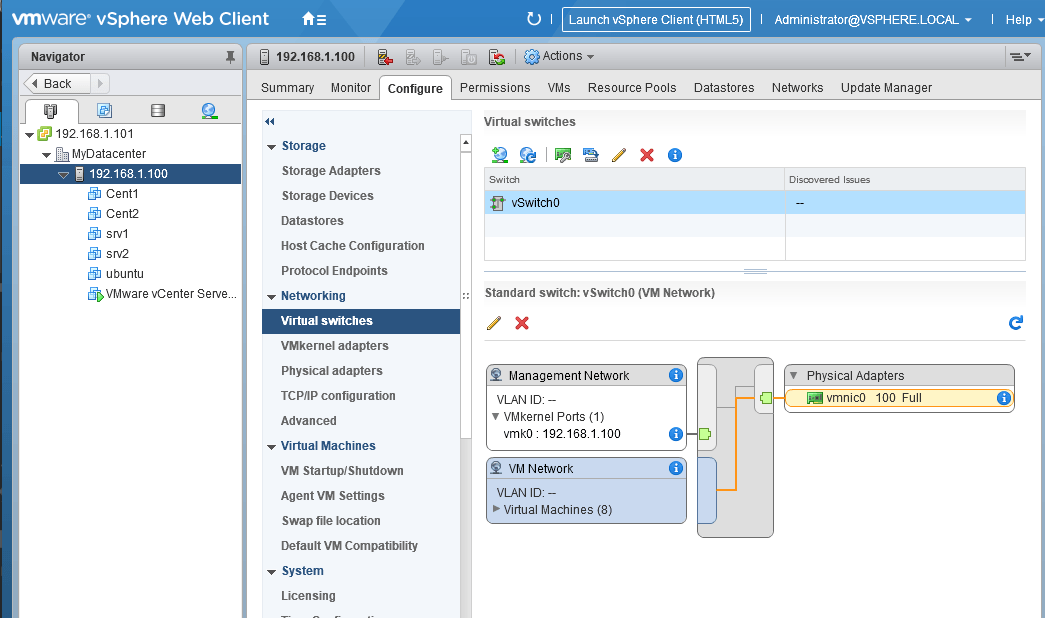

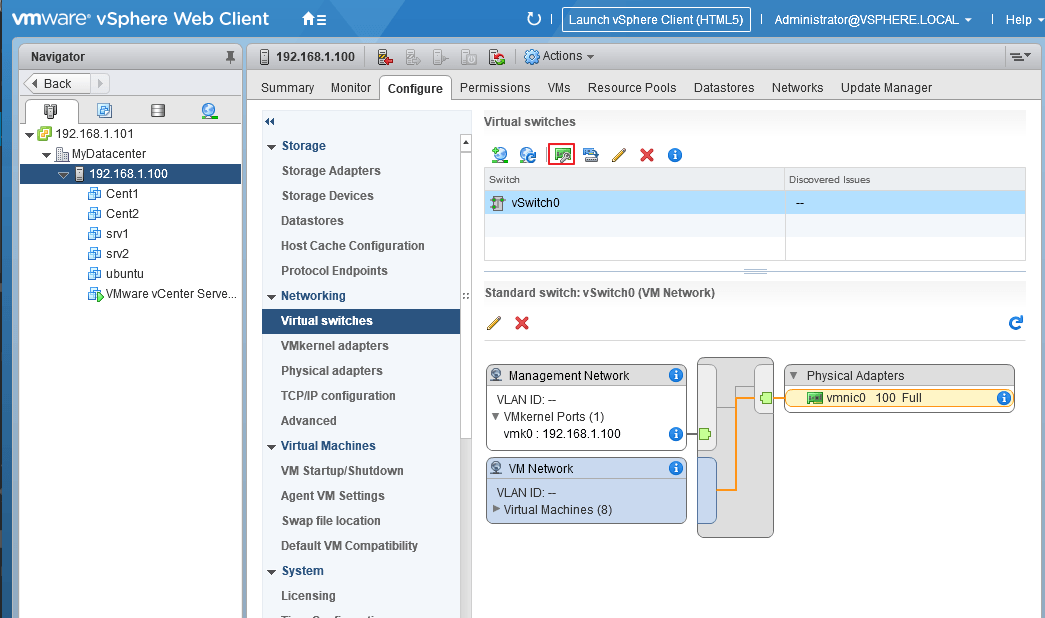

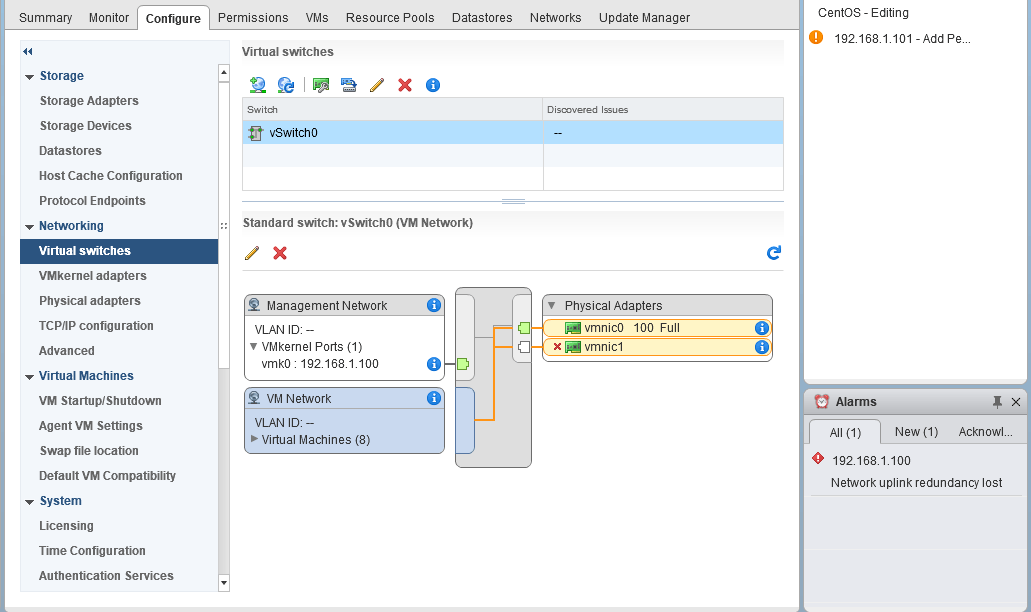

Для этого выбираем наш хост, жмем на вкладку Configure, и в разделе Networking выбираем Virtual Switches.

Поскольку у нас на хосте имеется два сетевых адаптера(как установить драйвер на неподдерживаемую сетевую карту мы рассматривале в статье), давайте добавим нашу сетевую карту в виртуальный свич и настроим так называемый тиминг(объединение сетевых интерфейсов).

Виртуальных коммутаторов на хосте может быть несколько. Если вы хотите, чтобы ваши виртуальные машины находились в изолированной сети, можно создать виртуальный коммутатор, не используя сетевые адаптеры.

Ну а мы рассмотрим настройку обычного виртуального свича.

VMware настройка сети

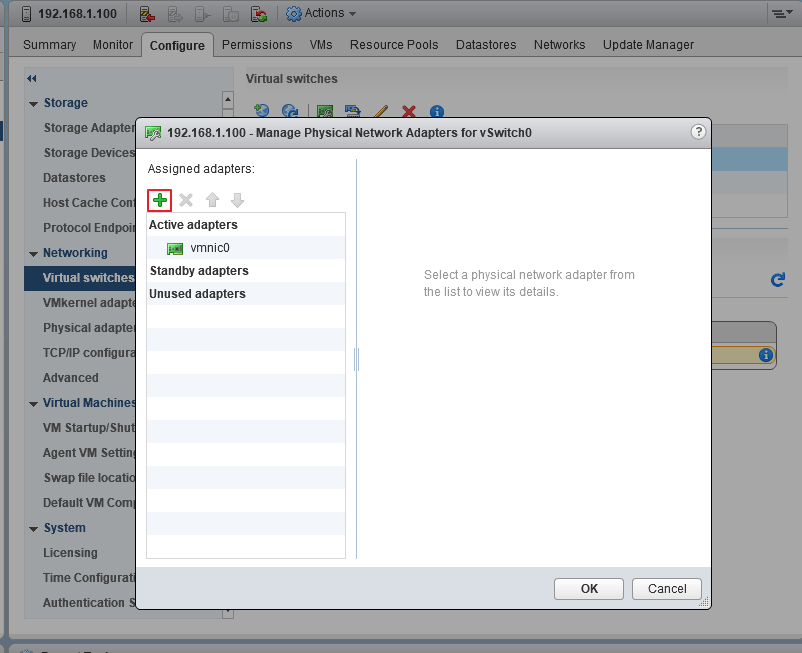

Выбираем наш единственный виртуальный коммутатор и нажимаем на значок сетевой карты

В открывшемся окне видим, что у нас сейчас активен один сетевой адаптер vmnic0. Жмем на зеленый плюс, чтобы добавить второй

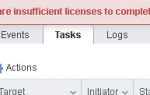

Видим нашу вторую сетевуху, выбираем ее и группу адаптеров, в которую нужно ее добавить(в нашем случае Active adapters).

Active adapters — сетевая карта будет использоваться

Standby adapters — сетевая карта будет задействована в случае выхода из строя основной

Unused adapters — сетевая карта не будет использоваться.

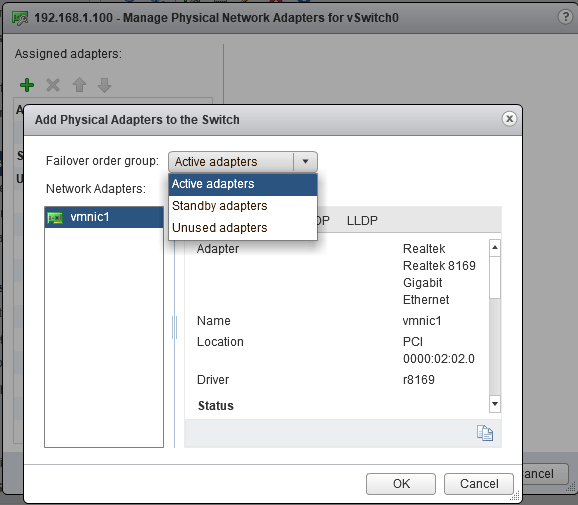

На следующем экране видим, что наши адаптеры находятся в группе активных(можно поменять группу адаптера с помощью синих стрелок, а также удалить адаптер или добавить еще).

Жмем ОК и видим, что теперь в нашем свиче два сетевых адаптера(у меня подключен только один, поэтому VMware «сигналит», что отказоустойчивость потеряна.

Читайте также: Как установить ESXi на обычный компьютер

В виртуальных свичах VMware есть сеть для виртуальных машин VM Network(сюда подключаются виртуальные машины) и VMkernel, предназначенный для служебного трафика(Management, VMotion, iscsi и т.п.).

Давайте настроим наш управляющий интерфейс, который используется для управления хостом.

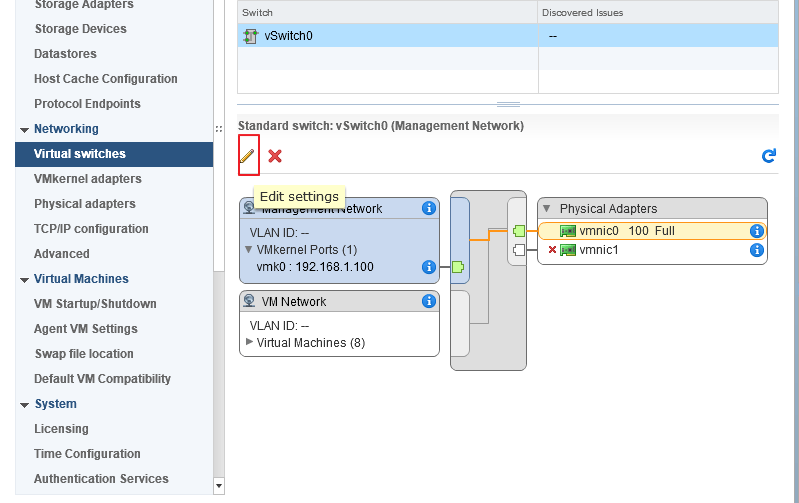

Выделяем окно с заголовком Management Network и нажимаем на карандаш для редактирования.

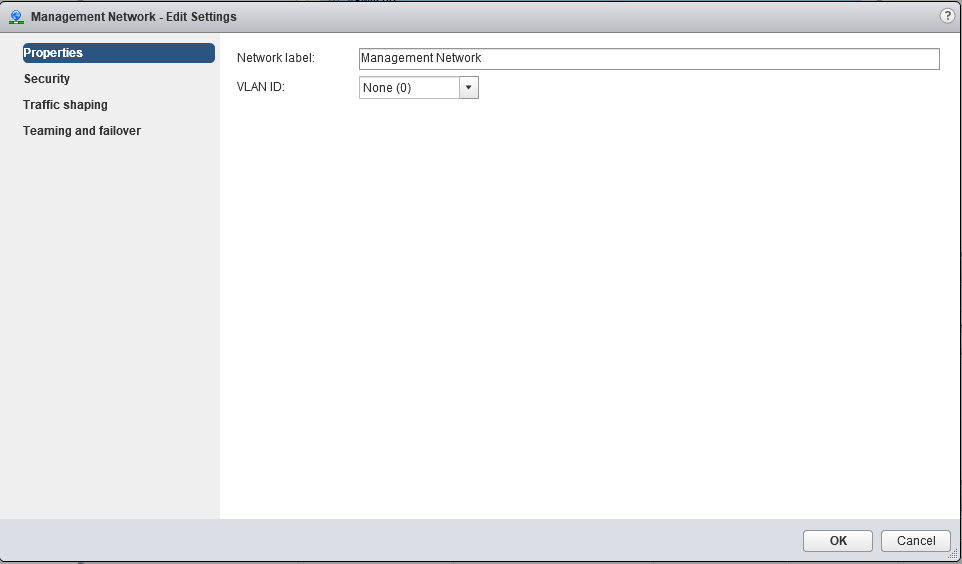

В настройках Management Network вы можете изменить название сети, VLAN(если используется), настройки безопасности, traffic shaping(в стандартном свиче ограничивается только исходящий трафик) и режим файловера и балансировки нагрузки.

Настройки по умолчанию вполне себе работают, поэтому оставим их без изменения. Если вас они не устраивают, можете выставить желаемые настройки(информацию по best practices можно поискать на сайте https://www.vmware.com).

Думаю, нужно еще рассмотреть настройки интерфейса VMkernel, используемого для служебных нужд.

Интерфейсов VMkernel может(и должно) быть несколько, чтобы разделить трафик управления от, например, трафика iscsi. Желательно, чтобы это были физически разделенные сети, ну или, хотя бы, на уровне VLANs.

Давайте настроим несколько таких интерфейсов.

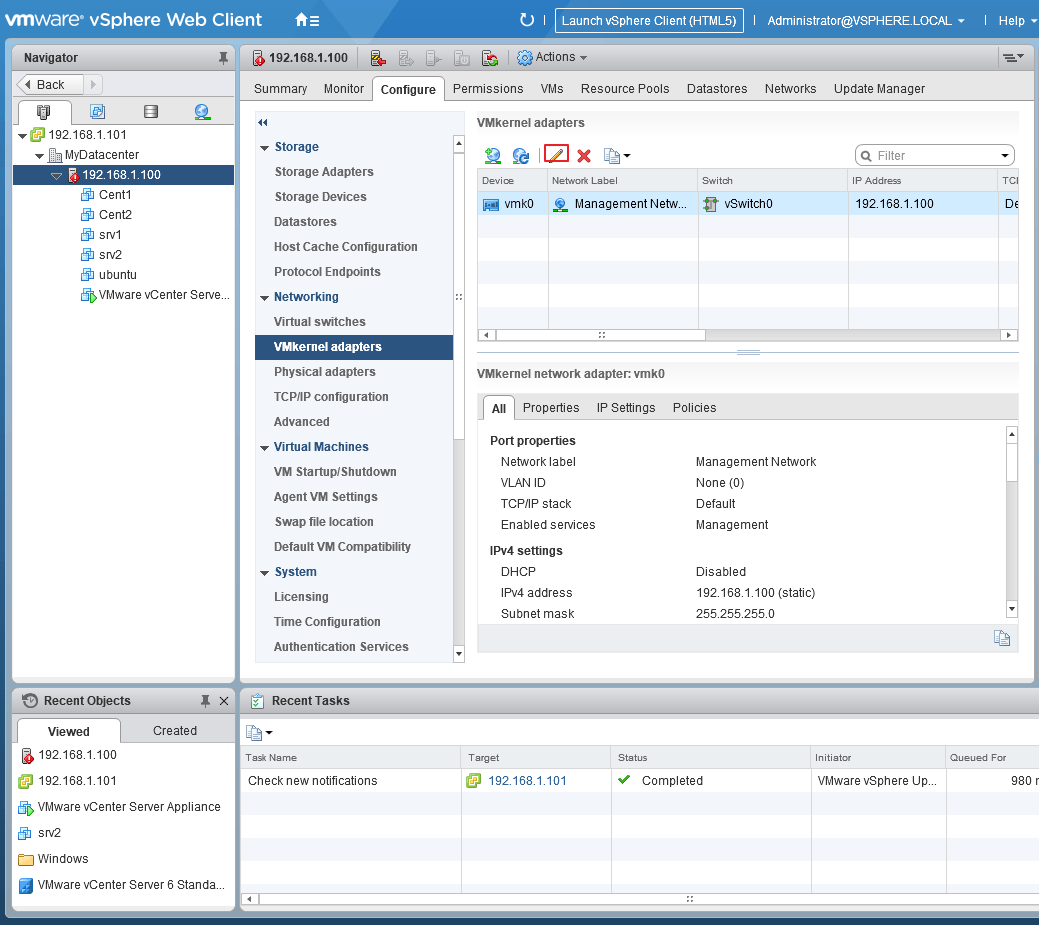

Выбираем в секции Networking вкладку VMkernel adapters, выделяем пока единственный vmk0 и жмем карандаш для редактирования

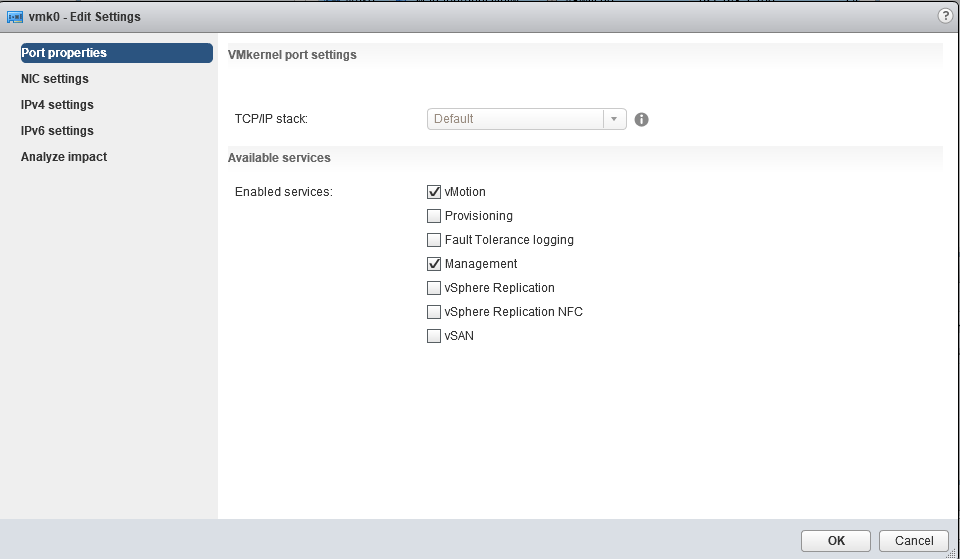

В открывшемся окне на первой вкладке выбираем тип трафика, который разрешен на этом интерфейсе(давайте разрешим здесь еще VMotion — трафик миграции ВМ).

На других вкладках этого мастера можно изменить такие настройки как MTU, настройки IPv4 и IPv6.

Читайте также: Как выгрузить список виртуальных машин VMware.

После нажатия ОК настройки будут сохранены.

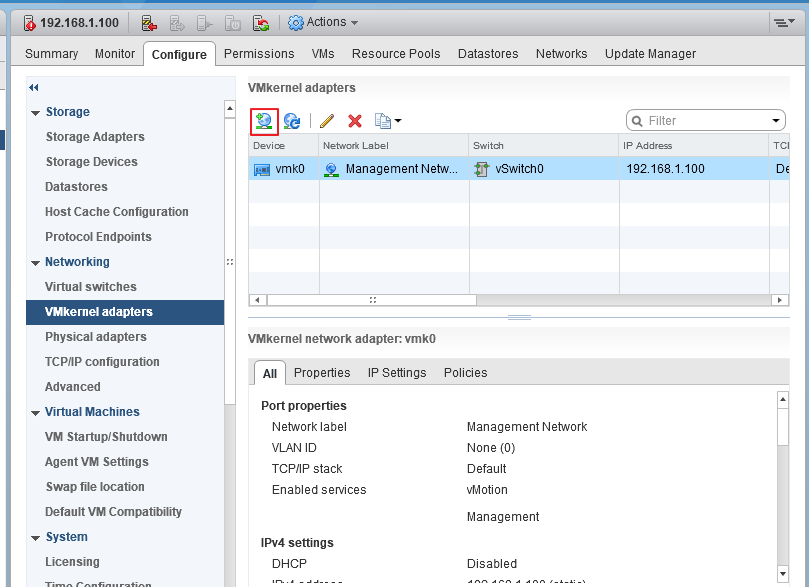

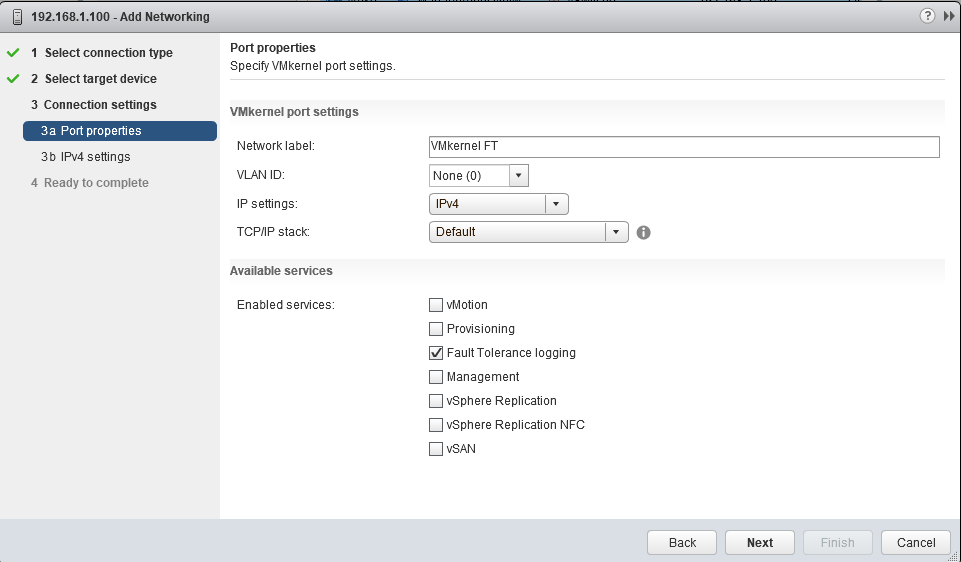

Теперь давайте создадим еще один VMkernel для трафика, например Fault Tolerance. Настройка сети для трафика хранилищ iscsi описана в статье Как подключить iscsi-lun к хосту esxi.

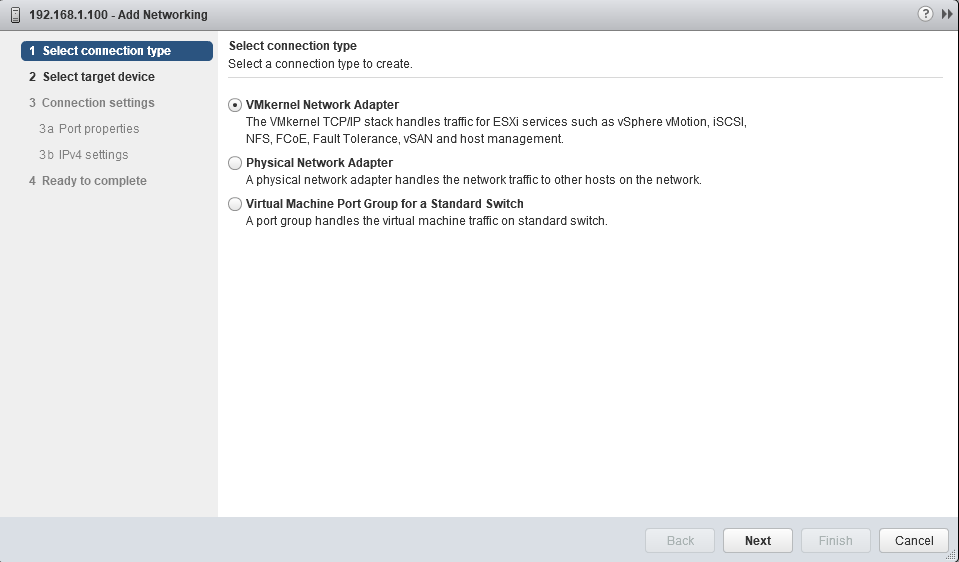

Итак, жмем на глобус с плюсом, чтобы добавить новый адаптер VMkernel

Выбираем тип VMkernel Network Adapter

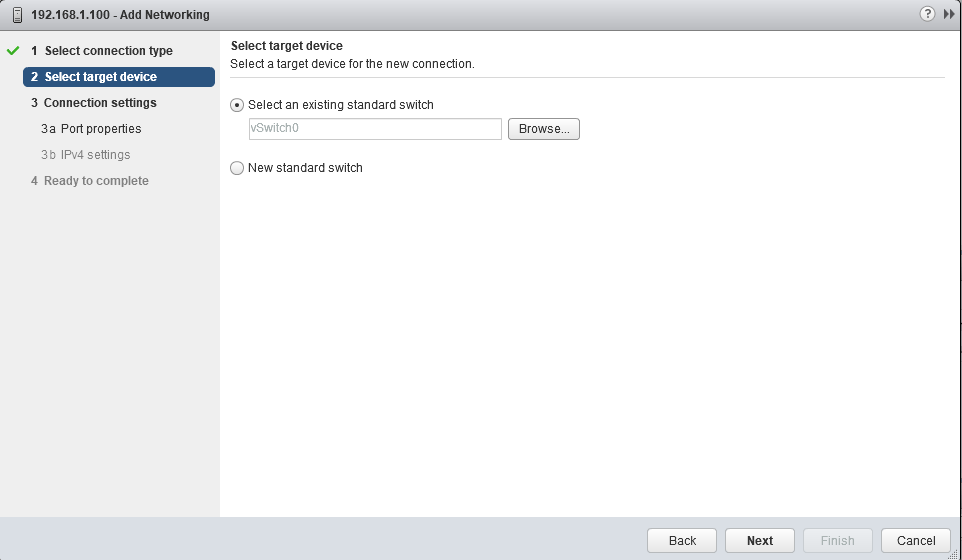

Выбираем, использовать имеющийся или создать новый виртуальный коммутатор(мы выберем наш единственный). Жмем Next.

На следующем экране задаем имя нашего адаптера, выбираем какой версии протокол IP будет использоваться и какой трафик

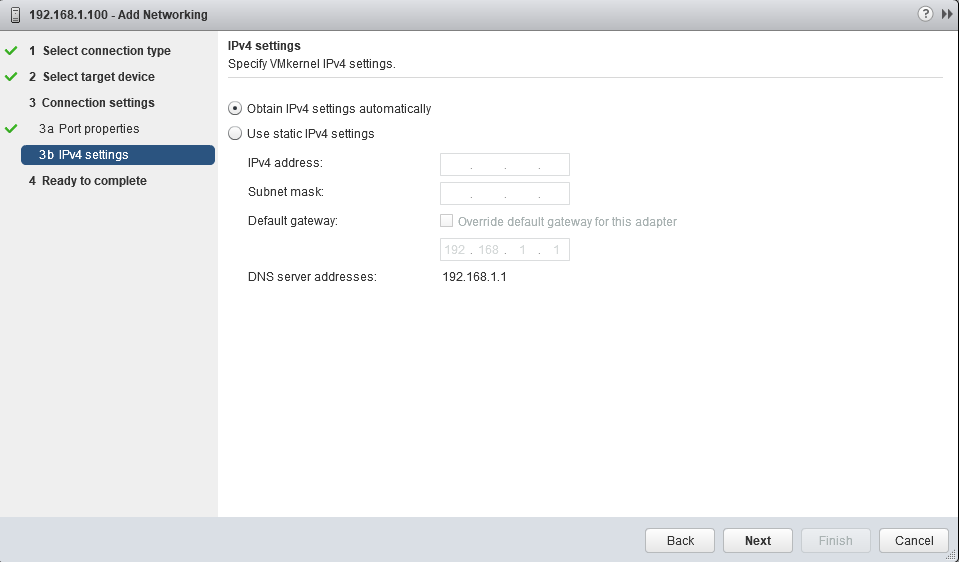

Указываем сетевые настройки(статика или DHCP)

На завершающем экране мастера проверяем настройки и жмем Finish.

Видим, что теперь у нас появился второй VMkernel адаптер, который будет использован для передачи трафика Fault Tolerance logging.

Сеть виртуальных машин создается аналогично, только в мастере нужно выбрать Virtual Machine Port Groupe

Выбрать или создать VSwitch

указать название сети и VLAN

и завершить создание

После этого в нашем виртуальном коммутаторе появится еще одна сеть виртуальных машин и в настройках виртуальных машин станет доступно подключение к этой сети.

Дополнительный виртуальный коммутатор можно создать при создании VMkernel или VM Network. Как я уже говорил, наличие физического сетевого адаптера требуется только, если ВМ должны иметь доступ к внешним ресурсам.

Ну вот вкратце и всё по настройке сети VMware. Если что-то осталось не рассмотренным или непонятным, пишите в комментариях, — будем дополнять.

Поделиться ссылкой:

Настройка сети VMware ESXi

Те администраторы, которые в первый раз настраивают сеть в VMware ESXi, могут столкнуться с некоторыми трудностями. Происходит это из-за того, что помимо сети физической, которая начинается от сетевых карт сервера (хоста ESXi) и уходит куда-то в физические свитчи, маршрутизаторы, интернет, есть сеть виртуальная.

Если ничего не настраивать, и установить ESXi на сервер, создать виртуальную машину, то ее сетевой интерфейс будет по умолчанию подключен к первой физической сетевой карте хоста. И все будет работать. Пока не придет пора настраивать подключение к iSCSI системе хранения данных или задействовать технологии высокой доступности: High Availability, Fault tolerance, vMotion.

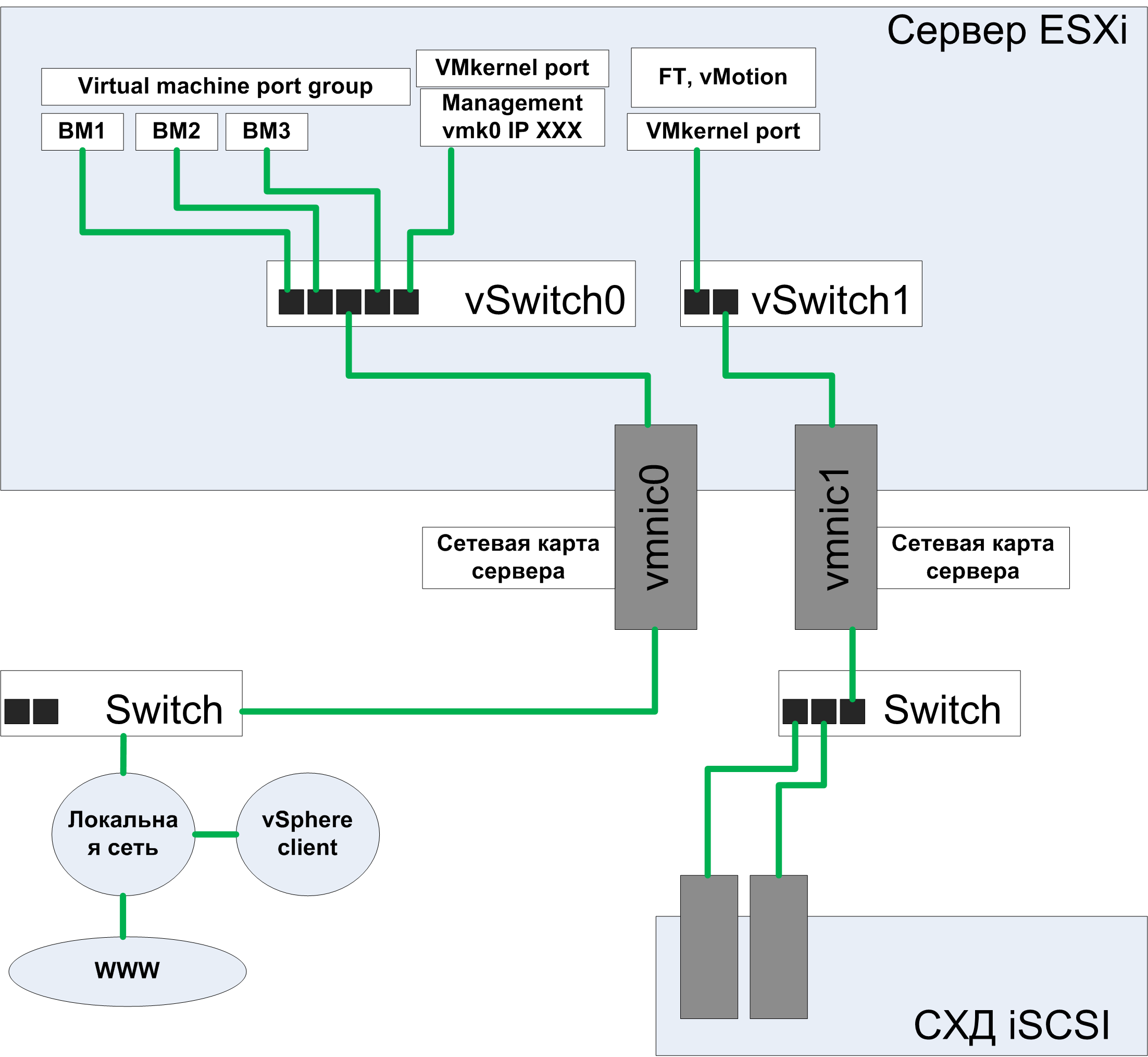

На схеме показан физический Сервер ESXi с двумя сетевыми интерфейсами vmnic0 и vmnic1.

Виртуальный свитч vSwich

Для простоты понимания, виртуальный свитч стоит представлять как физический, со всеми его свойствами и возможностями настройки. vSwitch0 создается по умолчанию в единственном числе, а в процессе настройки администратор может создавать дополнительные виртуальные свитчи, строить внутреннюю сеть хоста ESXi по своему усмотрению. С помощью виртуальных свитчей на ESXi сервере можно смоделировать любую сетевую схему, которую бы вы смогли сделать в реальной инфраструктуре.

Порт управления vmk

После первоначальной установки гипервизора ESXi, мы видим на экране, что для управления нужно подключиться к IP адресу XXX. Этот IP адрес автоматически (если в сети работает DHCP) присвоен порту vmk0, который подключен к виртуальному свитчу vSwitch0, к нему же подключена физическая сетевая карта vmnic0.

Теперь администратор для управления хостом ESXi запускает vSphere Client у себя на рабочей станции, вводит IP XXX и по цепочке Локальная сеть -> Switch -> vmnic0 -> vSwitch0 -> vmk0 подключается к интерфейсу управления.

Группа портов для виртуальных машин

Virtual machine port group создается автоматически при установке гипервизора ESXi на сервер. Сюда присоединяются сетевые интерфейс(ы) виртуальных машин.

Цепочка такая:

- Сетевая карта виртуальной машины должна принадлежать какой-нибудь порт группе.

- Порт группа должна быть присоединена к какому-нибудь виртуальному свитчу

- Виртуальный свитч может быть присоединен к физическим(ой) сетевым картам или может не иметь выхода в общую сеть

При желании, администратор может создавать дополнительные группы портов для виртуальных машин и присоединять их к любым vSwitch.

Сетевые карты одной ВМ могут быть в разных группах портов, таким образом, можно настраивать полноценные маршрутизаторы или DMZ.

Подключение СХД

Имеет смысл разделять сеть виртуальных машин и сеть передачи данных СХД<->хост ESXi. На схеме для этого используется дополнительный VMkernel порт и vSwitch1, подключенные к vmnic1. При такой архитектуре два потока данных не пересекутся и не будут мешать друг другу. Также повышается безопасность, злоумышленник, имея доступ к локальной сети компании, ни при каких обстоятельствах не сможет попасть в сеть передачи и хранения данных. Под системами хранения данных здесь понимаются iSCSI и NFS хранилища. FC СХД изначально имеет свою сеть передачи данных, оптическую.

Трафик vMotion, FT, management

Отдельную сеть точно также как и для СХД полезно выделять еще для 3-х типов трафика.

- vMotion трафик создается при миграции ВМ с хоста на хост

- Fault Tolerance трафик создается при синхронизации двух виртуальных машин, оригинала и дубликата

- Management трафик, это тот, который на схеме на vmk0, его, обычно, оставляют в общей сети.

При работе в среде виртуализации VMware часто требуется воссоздать сетевую инфраструктуру. Поскольку машины виртуальные и физических интерфейсов у них конечно же нет, то и сети будут виртуальными.

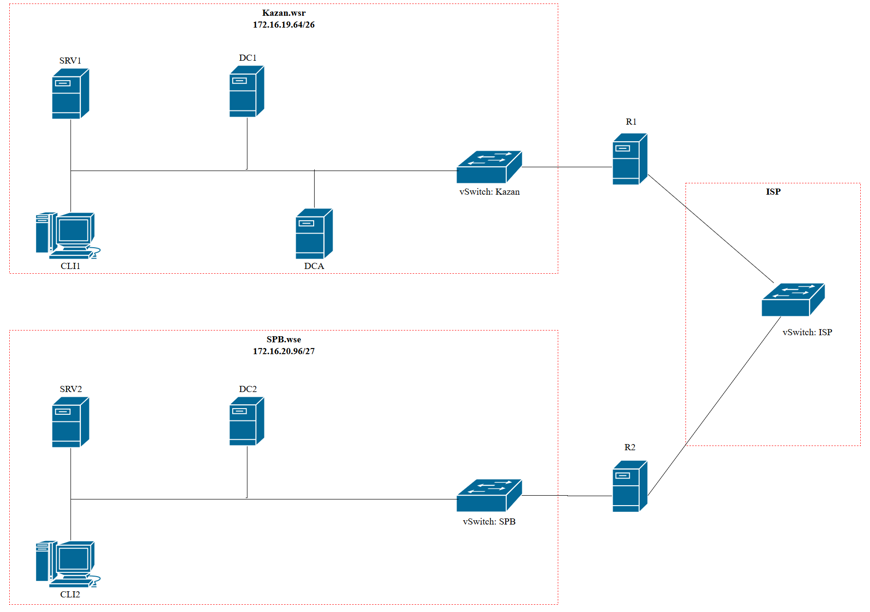

Рассмотрим создание виртуальной сети на следующем примере:

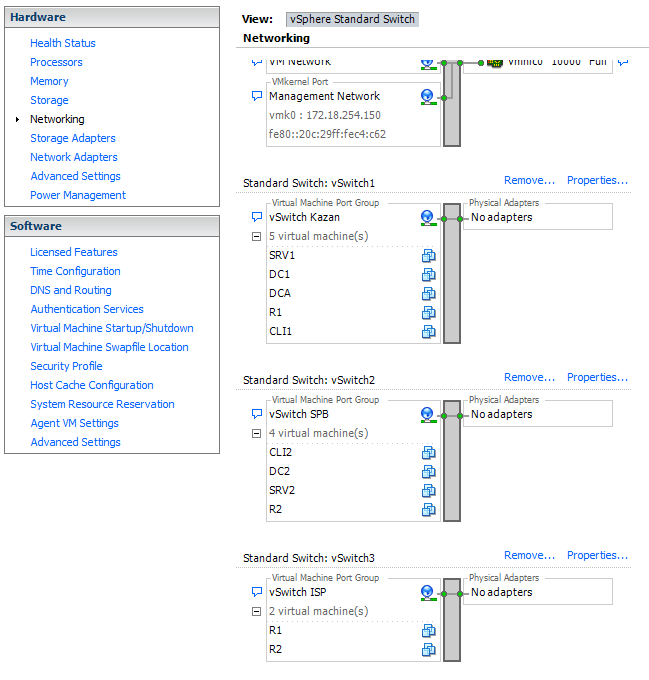

Для реализации данной схемы нам потребуется 3 виртуальных коммутатора (vSwitch).

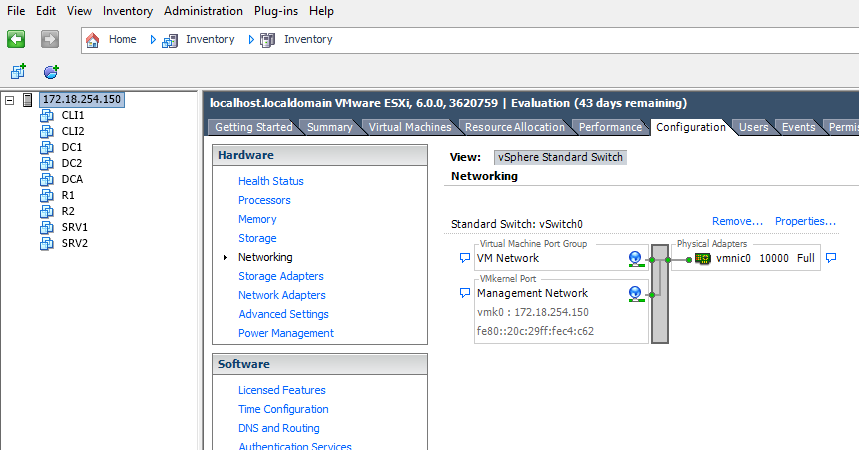

Для создания виртуального коммутатора необходимо подключиться к гипервизору с помощью клиента vSphere Client.

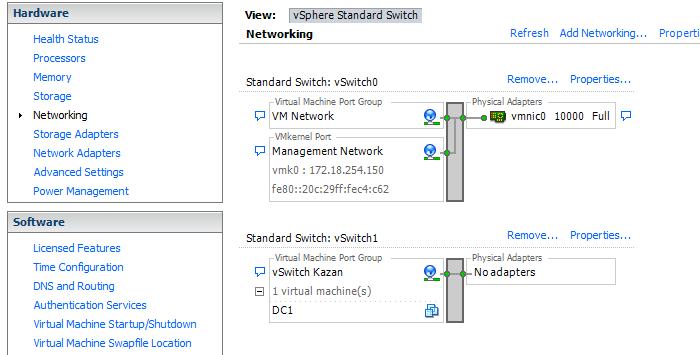

В представленном примере уже есть один виртуальный коммутатор, который был создан автоматически при установке гипервизора. Мы не будем его трогать, поскольку, он может понадобиться для других машин. Создадим полностью независимый фрагмент сети, дабы исключить незапланированное взаимодействие между виртуальными машинами.

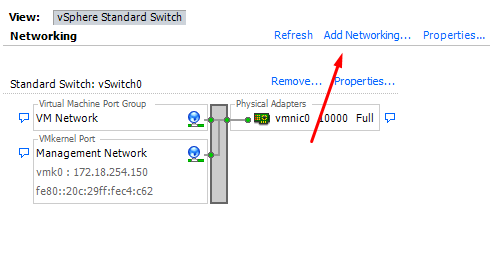

Для создания виртуального коммутатора нажмем на пункт Add Networking.

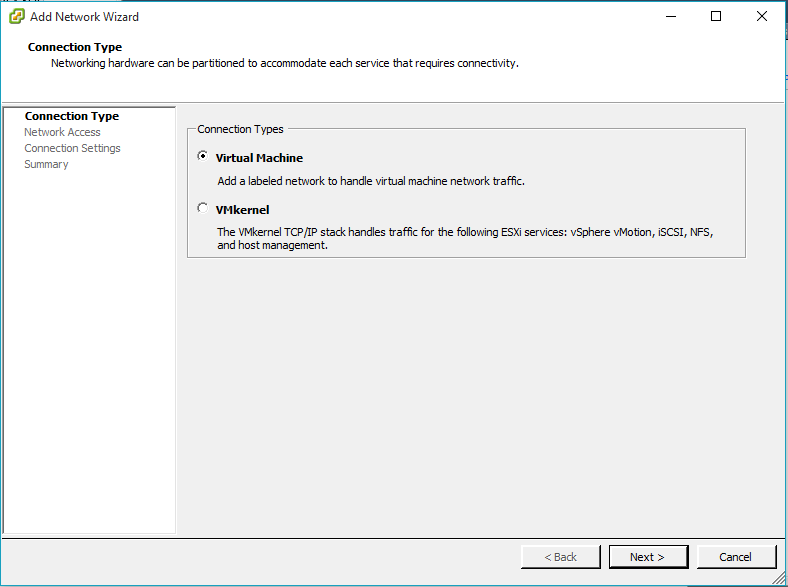

На первом шаге мастера создания сетевого выбираем Virtual Machine.

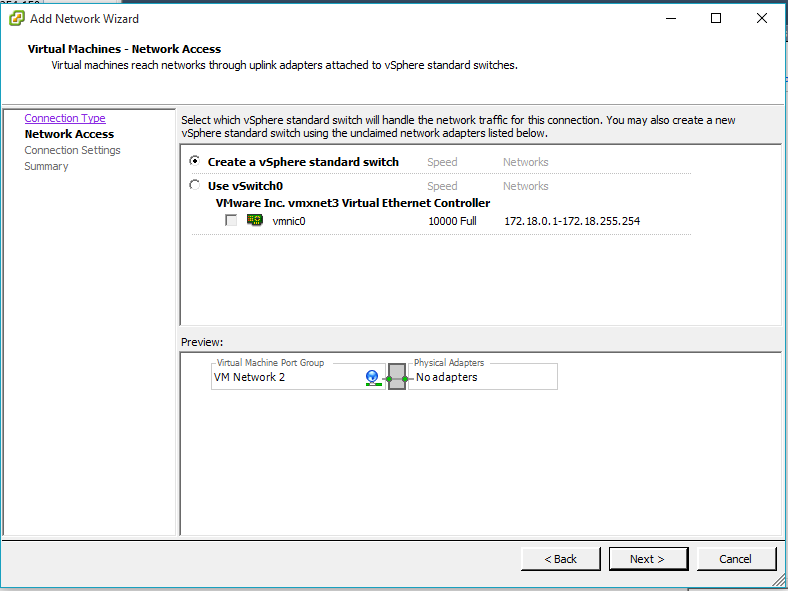

На следующем шаге выберем пункт Create a vSphere standart switch.

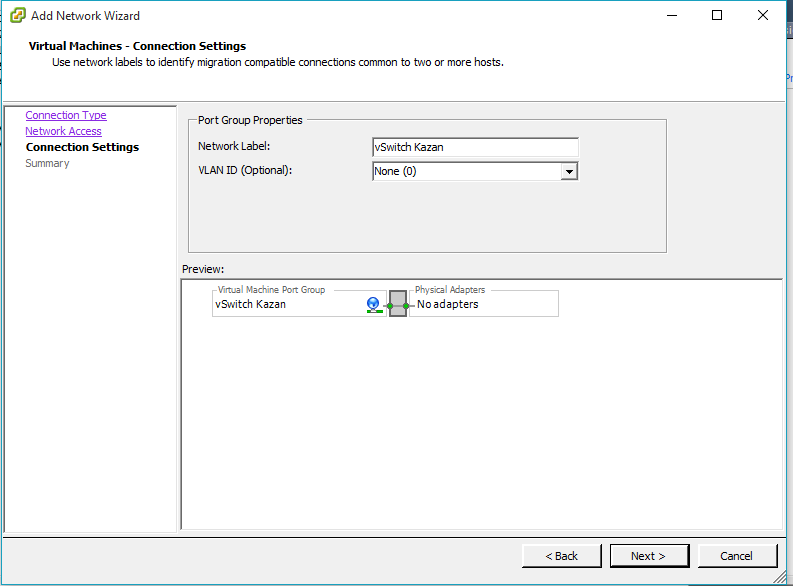

На шаге Connection Settings задаем параметры коммутатора главным из которых будет Network Label. Желательно называть сеть понятным названием которое можно легко отличить от других и понимать что к чему…

В результате в сетевых настройоках хоста появится новый виртуальный свитч.

Аналогичным образом создаем остальные коммутаторы.

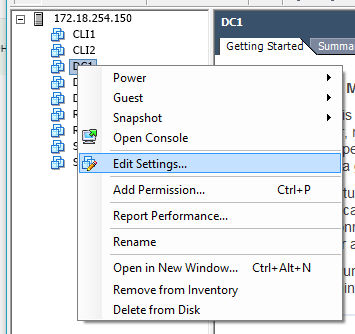

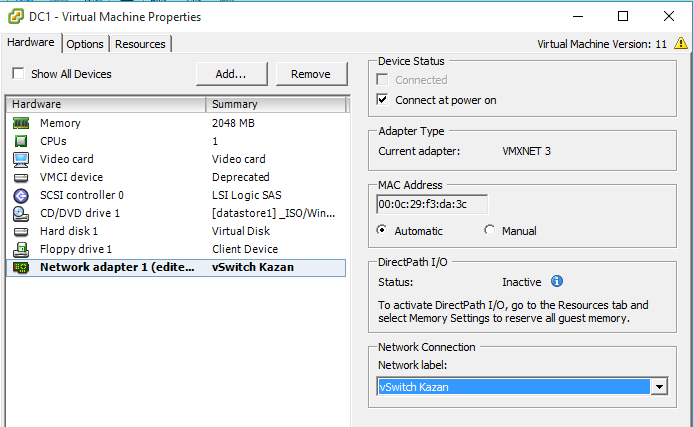

После завершения работы мастера Добавления сети необходимо произвести настройку виртуальных машин. Выбираем машину, которую нужно настроить, в нашем случае это DC1.

На вкладке Hardware выбираем сетевой адаптер и в секции Network Connection выбираем только что созданную сеть.

Подобную настройку проводим на всех виртуальных машинах. По завершению настройки сетевая диаграмма должна принять примерно такой вид:

Используемые источники:

- https://fun-admin.ru/virtualizaciya/vmware/vmware-nastrojka-seti/

- http://www.vmstart.ru/tso-kalkulyator/312-vmware-set

- https://poligon218.ru/2019/09/10/настройка-виртуальной-сети-в-гиперви/

Установка esxi 6.5, с правильной настройкой

Установка esxi 6.5, с правильной настройкой

Установка и базовая настройка бесплатного VMware vSphere Hypervisor

Установка и базовая настройка бесплатного VMware vSphere Hypervisor

Настройка высокой доступности (HA) для VMWare vCenter 6.5

Настройка высокой доступности (HA) для VMWare vCenter 6.5

Как создать виртуальную машину VMware Workstation и установить на неё Windows

Как создать виртуальную машину VMware Workstation и установить на неё Windows Настройка локальной сети между компьютером и виртуальной машиной VMware Workstation

Настройка локальной сети между компьютером и виртуальной машиной VMware Workstation VDI для всех: cпецификация VMware Horizon 7

VDI для всех: cпецификация VMware Horizon 7 Настройка локальной сети между виртуальными машинами VMWare и хостом

Настройка локальной сети между виртуальными машинами VMWare и хостом