Получить Proxmox VE можно на официальном сайте, сейчас доступна новая версия 6.0, которую мы и будем устанавливать. Да, это действительно open-source и это бесплатно, корпоративная подписка предоставляет доступ к закрытому репозиторию Proxmox VE Enterprise, который содержит стабильные обновления ПО и обновления безопасности, а также техническую помощь и поддержку. Никаких ограничений функциональности, если вы откажетесь от подписки, нет.

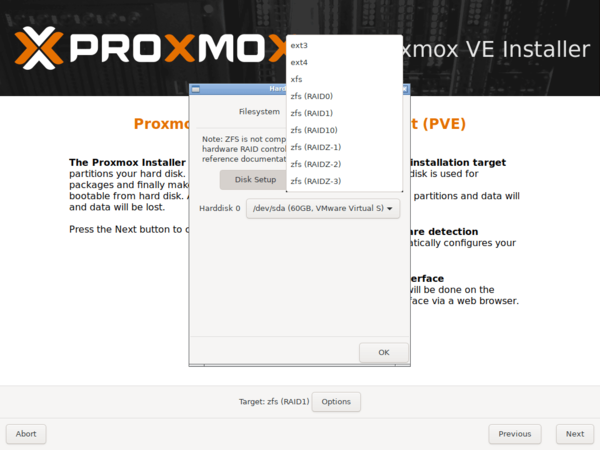

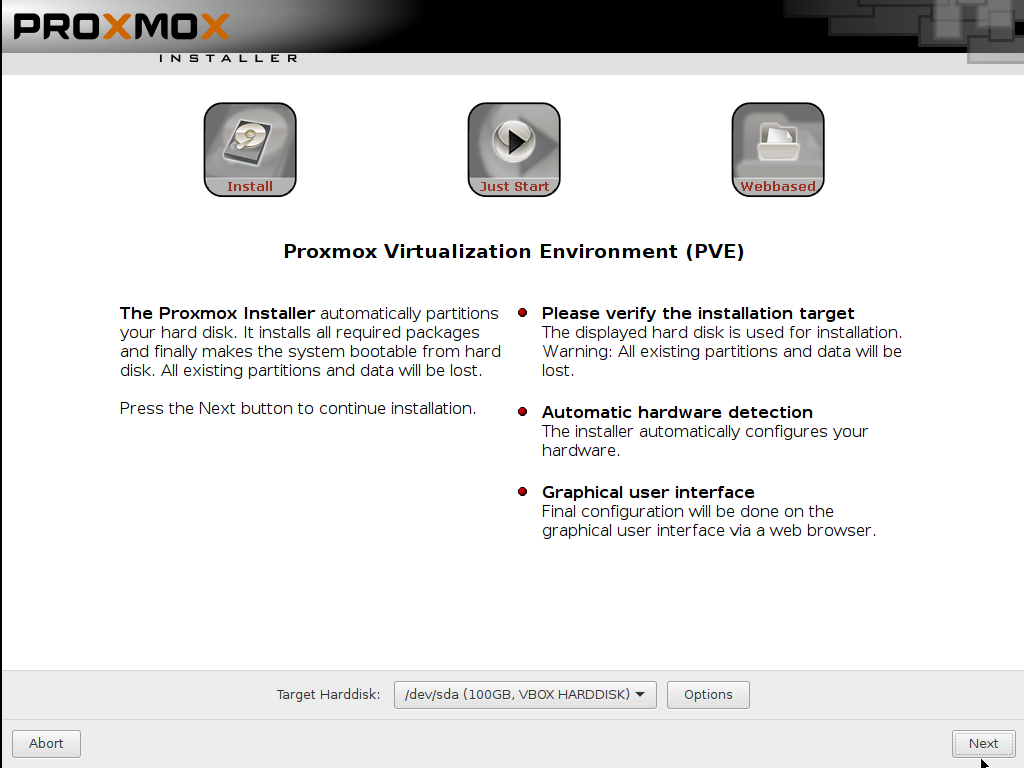

Для установки используется собственный инсталлятор и весь процесс предельно прост, от вас потребуется указать конфигурацию дисковой подсистемы:

Но не будем спешить. Прежде всего отключим корпоративный репозиторий, на который у нас все равно нет подписки, и подключим вместо него некоммерческий репозиторий Proxmox. Для отключения просто удалим файл репозитория из источников apt:

rm -f /etc/apt/sources.list.d/pve-enterprise.listЗатем создадим свой список:

touch /etc/apt/sources.list.d/pve-no-subscription.listВ который внесем следующие строки:

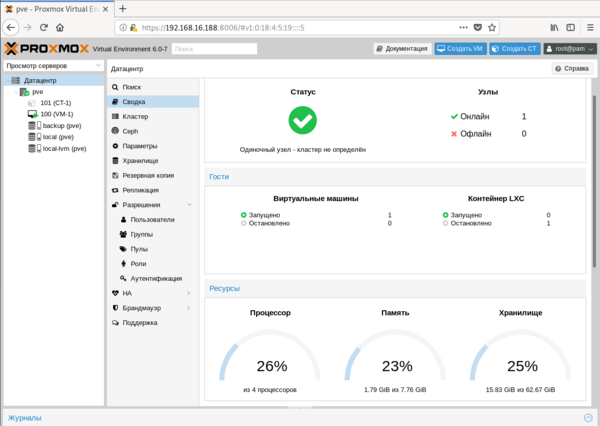

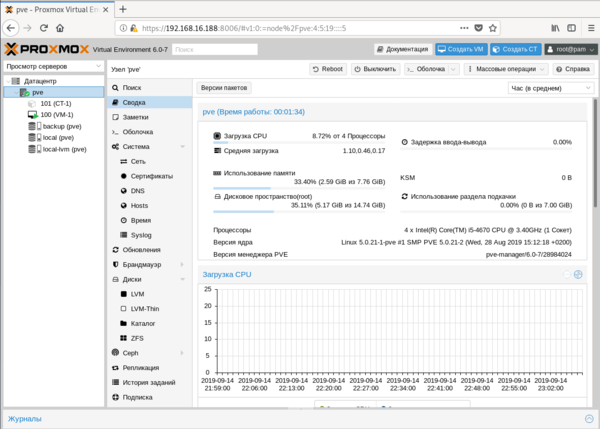

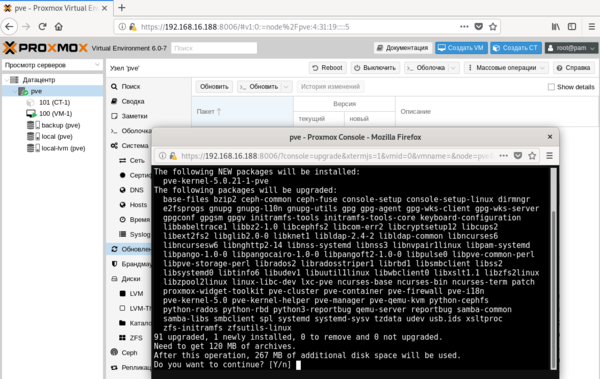

deb http://download.proxmox.com/debian/pve buster pve-no-subscriptionТеперь можно переходить к консоли управления, откроем браузер и наберем предложенный адрес, консоль управления продуктами Proxmox работает на порту 8006, что следует помнить.

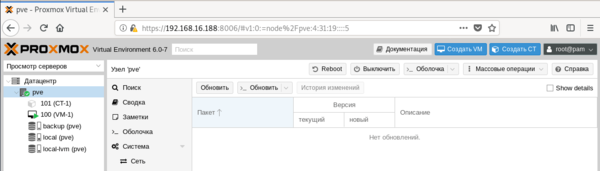

Но есть и «сложности перевода», так в разделе Обновления, нас ждут две одинаковые кнопки Обновить.

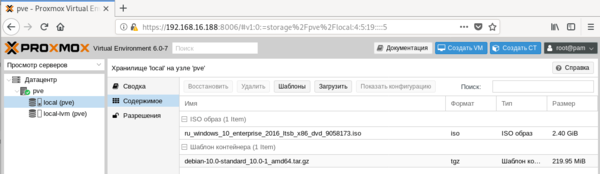

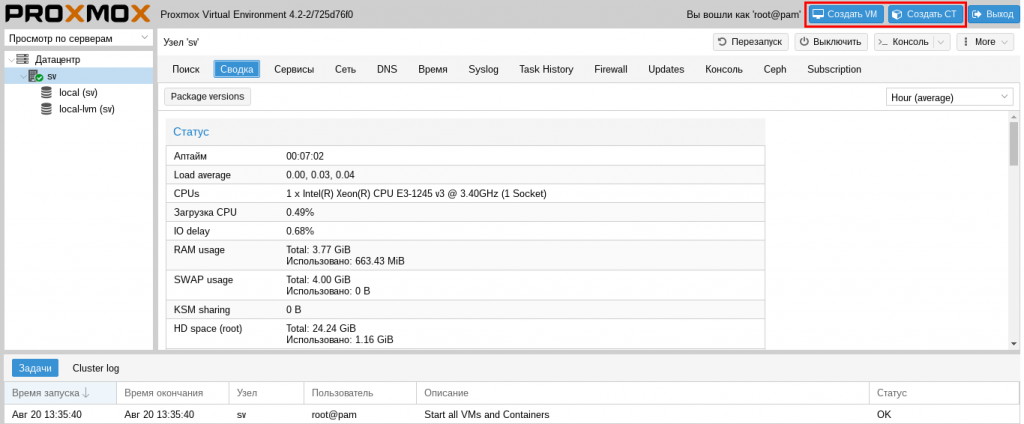

Перед тем, как создавать виртуальные машины и контейнеры, обратимся к Хранилищам, по умолчанию создается два хранилища: local и local-lvm.

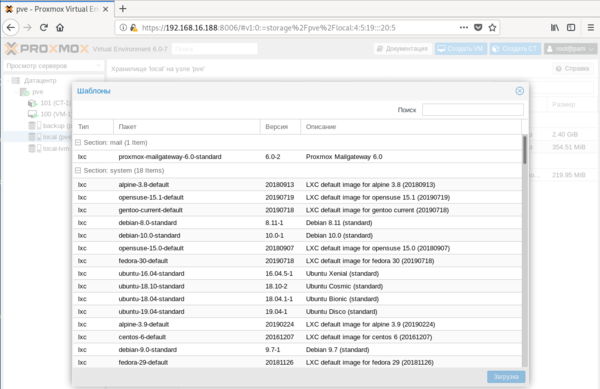

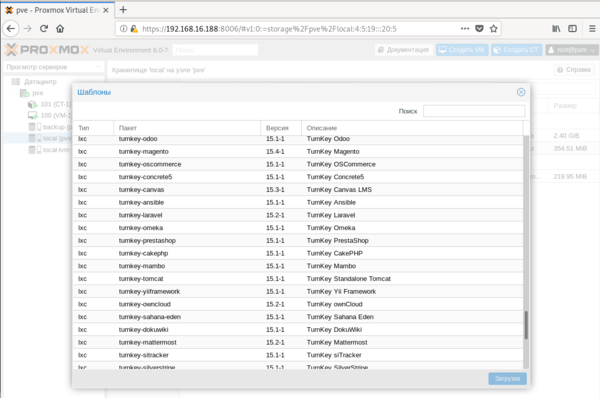

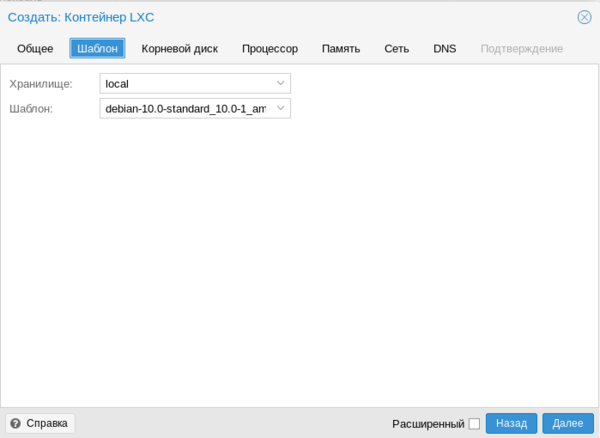

Для получения шаблонов следует нажать кнопку Шаблоны и мы попадем в официальное хранилище шаблонов, здесь мы может сразу загрузить шаблон другого продукта Proxmox — Mail Gateway или шаблоны стандартных Linux-систем.

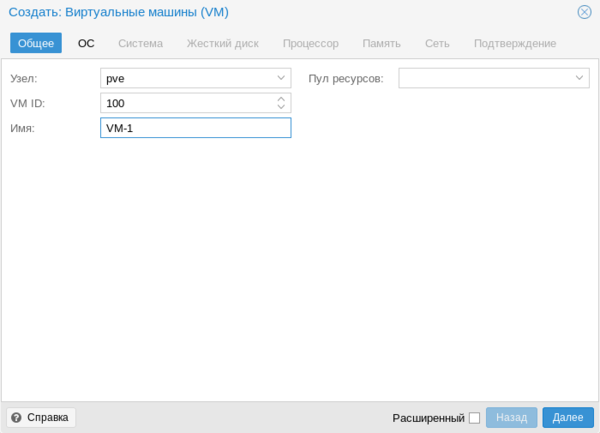

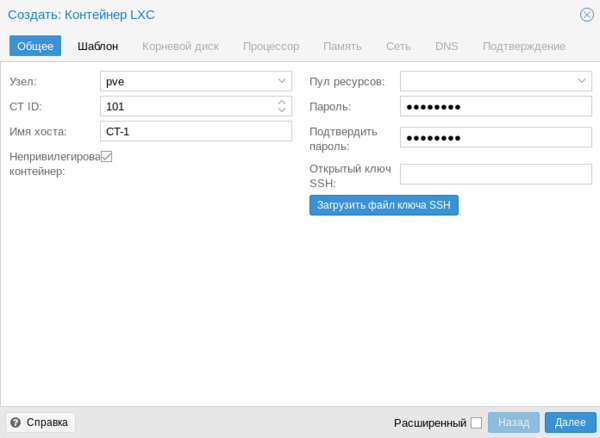

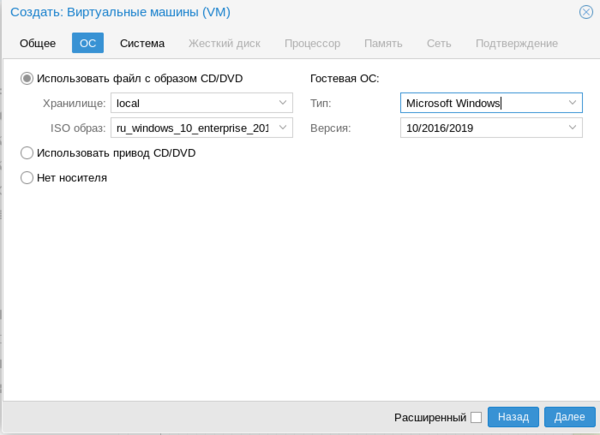

Для создания виртуальной машины нажмем Создать VM. На первом экране укажем имя виртуальной машины:

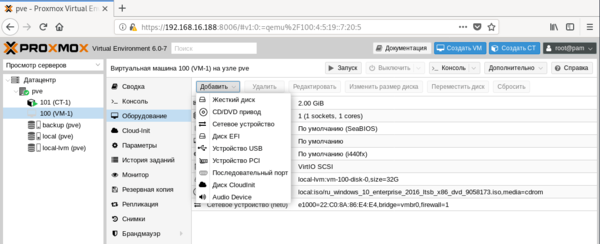

После чего, последовательно перемещаясь по пунктам следует настроить все остальные параметры виртуалки, особых сложностей это составить не должно. Но создав виртуальную машину не спешите ее запускать. Прежде всего перейдем в раздел Оборудование. Здесь можно не только настроить уже подключенное оборудование, но и добавить новое. В отличие от Hyper-V, Proxmoх позволяет пробрасывать внутрь виртуальных машин USB-устройства, что может быть полезным, если вам нужно работать с ключами защиты или USB-токенами.

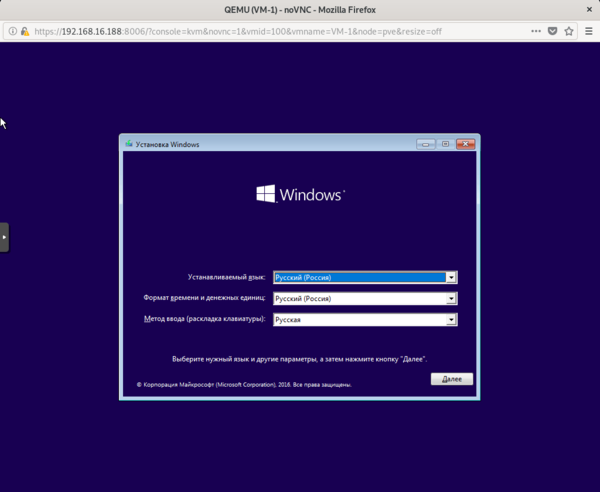

Итак, все настройки закончены, включаем виртуальную машину и переключаемся в консоль. Да, прямо в браузере вы увидите экран вашей виртуалки, при этом ничего не тормозит, работать с системой достаточно комфортно.

Обратите внимание, что запущенный контейнер с Debian 10 потребляет всего лишь 55,46 МБ оперативной памяти.

Тем временем, пока мы создавали контейнер, должна была установиться наша виртуальная машина. После установки ВМ потребуется установить в нее QEMU-агента для полноценного взаимодействия с гипервизором. Для Linux систем все просто, на deb-based системах достаточно выполнить:

apt install qemu-guest-agentДля других дистрибутивов следует установить пакет qemu-guest-agent штатным пакетным менеджером.

С Windows все несколько сложнее, прежде всего скачаем и поместим в хранилище Proxmox ISO-образ с virtIO драйверами. Получить его можно со страницы Fedora Project. Затем подключим скачанный образ к виртуальной машине.

При включенном QEMU-агенте мы увидим три неустановленных устройства.

Начнем с последнего, для Драйвера прерываний кнопок HID перейдем в выбор из списка уже установленных драйверов и укажем драйвер Универсальной шины.

Для двух оставшихся выполним поиск драйверов на смонтированном диске и устанавливаем драйвер VirtIO Serial Driver, который отвечает за работу QEMU-агента:

И VirtIO Balloon Driver, который отвечает за динамическое управление памятью. При работающем QEMU-агенте внизу окошка со сведениями о виртуальной машине вы увидите ее IP-адрес, в противном случае там будет сообщение, что QEMU-агент не установлен.

Также вы можете теперь включить для виртуальной машины динамическую память, для этого установите флаг Раздувание памяти и укажите минимальный размер оперативки, с которой начнет работу виртуалка:

Но придерживайтесь при этом разумных пределов, так вы можете столкнуться с невозможностью запустить современные версии Windows если укажете минимальный размер памяти менее 1 ГБ.

Еще одна важная функция, которая доступна в Proxmox VE — это резервное копирование. Существует хорошая практика — хранить резервные копии за пределами хоста. Поэтому подключим к Proxmox сетевое хранилище, для этого перейдем в Датацентр — Хранилище. Выбор здесь достаточно богатый: iSCSI, NFS, CIFS и прочее.

В нашем случае мы подключим CIFS (SMB) хранилище.

Укажите имя хранилища, в нашем случае backup, его IP-адрес или FQDN-имя, доступные ресурсы будут просканированы автоматически и вам останется только выбрать их из списка, в поле Содержимое укажите Резервная копия , а также не забудьте указать максимальное количество резервных копий в хранилище.

Затем перейдем в раздел Резервная копия и создадим новый сценарий резервного копирования:

Особых сложностей там нет, выбираете нужные виртуальные машины или контейнеры и задаете расписание копирования. После чего вам только останется проверить, что резервные копии действительно создаются.

Как видим, Proxmox представляет собой вполне серьезный и самодостаточный продукт, способный стать основой вашей системы виртуализации, предоставляя возможности на уровне дорогих коммерческих гипервизоров.

Приветствую вас дорогие читатели на второй части цикла статей про домашний сервер!

Список цикла статей:

Для скачивания образа системы необходимо перейти на официальный сайт www.proxmox.com и скачать необходимую версию. Особых отличий в заливке или установке не будет. На момент написания статьи доступны версии 6 и 5.4 Берем какую либо флешку и пишем ISO образ на неё с помощью специальных программ. Их много (Rufus, balenaEtcher и др.). Я предпочитаю balenaEtcher. Там все просто до безобразия. Запустили, выбрали образ, убедились, что выбрана нужная флешка и нажали запись. Подождали и вытащили флешку. Есть Portable версия.

Подключаем флешку к серверу и продолжаем уже через монитор или IPMI/BMC интерфейс.</p> Что такое IPMI? Выдержка из Wikipedia: IPMI (от англ. Intelligent Platform Management Interface) — интеллектуальный интерфейс управления платформой, предназначенный для автономного мониторинга и управления функциями, встроенными непосредственно в аппаратное и микропрограммное обеспечения серверных платформ. Ключевые характеристики IPMI — мониторинг, восстановление функций управления, журналирование и инвентаризация, которые доступны независимо от процессора, BIOS’a и операционной системы. Функции управления платформой могут быть доступны, даже если система находится в выключенном состоянии. Что такое BMC? Это “мозг” IPMI, отдельный микроконтроллер. BMC (Baseboard Management Controller). Через него как раз и происходит удаленное управление сервером. По сути, BMC ― это отдельный компьютер со своим программным обеспечением и сетевым интерфейсом, который распаивают на материнской плате или подключают как плату расширения по шине PCI management bus. В моем случае она уже есть на материнской плате. На практике это выглядит так:

Для чего я это пишу тут? А для того, чтобы вы понимали, как можно управлять сервером не подключая к нему никаких мониторов, клавиатур и мышей. И в чем особенность серверных материнских плат. На обычных предназначенных для дома или игровых вы такого не увидите.

Установка Proxmox VE на сервер

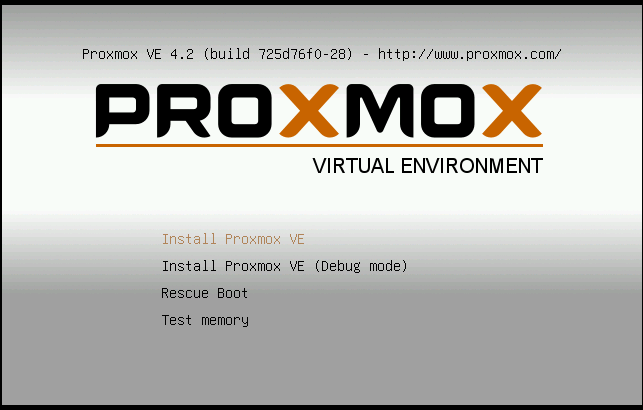

Для демонстрации буду использовать версию 5.4-1, как более близкую к своей 5.3-11, хоть она и поновей, но существенных изменений там нет. Все изображения спрятаны под спойлеры для вашего удобства!

Ожидаем окончания загрузки системы установки…

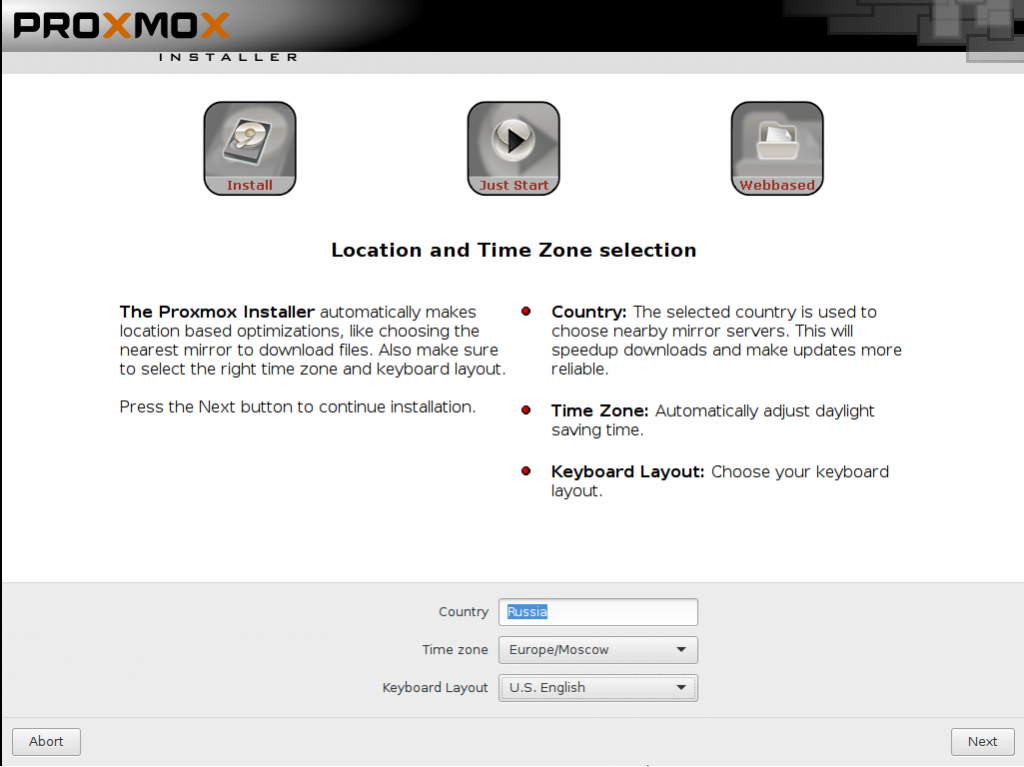

Тут хочется остановиться более подробно.

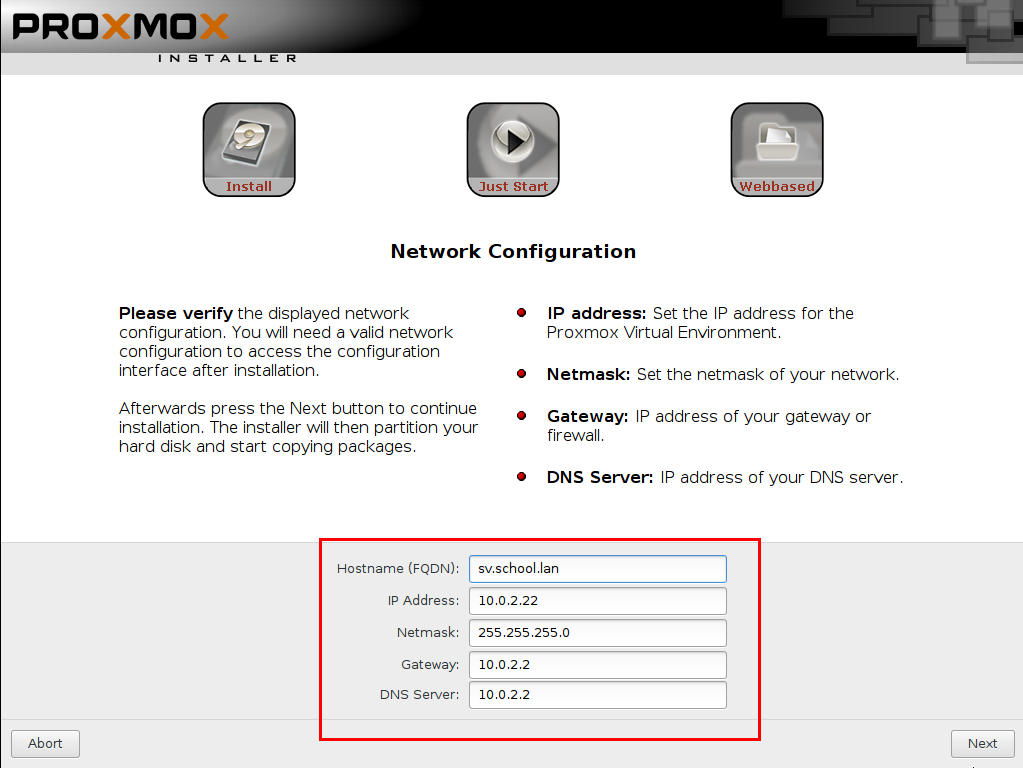

- Учтите сразу, у Proxmox сеть указывается вручную. Я несколько раз пробовал настраивать DHCP-Client для него, но почему-то он его не очень любит. Потому биндинг адреса в DHCP-Lease особого смысла не имеет, разве только, чтобы понимать какой девайс на нем сидит. Hostname (FQDN): рекомендую задавать осмысленно с учетом того, какое доменное имя планируете использовать. Это необходимо для следующей статьи по DNS. Вы же планируете заходить по доменному имени, а не по IP адресу, правда? ? Я задал свой pve1.gregory-gost.ru и по такому URL теперь захожу на WEB интерфейс Proxmox. Подумайте заранее!

- Я указал в DNS IP контейнера в котором у меня работает DNS служба, но вам для начала необходимо указать свои стандартные DNS. Иначе PVE не будет иметь нормального выхода в интернет. Часто совпадает с Gateway.

И наконец, после непродолжительных процедур нам позволено войти в систему.

Как можно наблюдать нам вежливо сообщили о том, по какому адресу и порту работает WEB интерфейс PVE:https://192.168.88.5:8006 Давайте зайдем и посмотрим, что там!

Обратите особое внимание на адрес по которому работает WEB интерфейс PVE! Как можно не сразу заметить используется защищенный протокол https вместо http. Автоматического перенаправления в системе не предусмотрено! Будьте внимательны!

Настройка Proxmox VE после установки

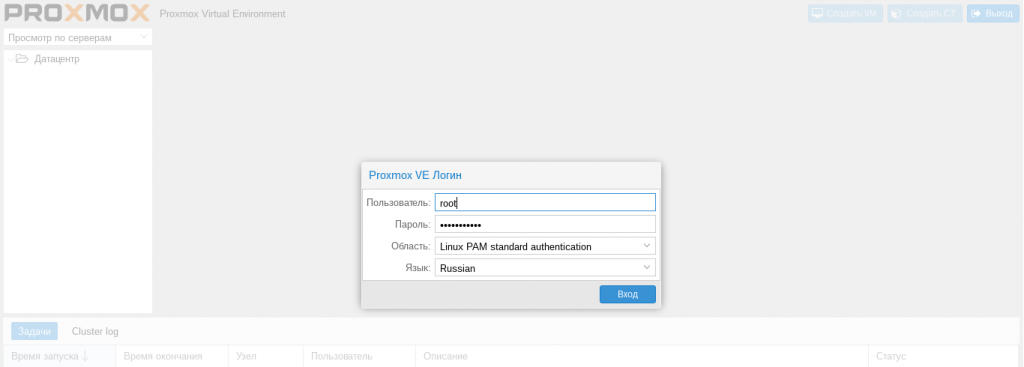

После ввода в браузере нужного адреса перед нами предстает WEB интерфейс PVE

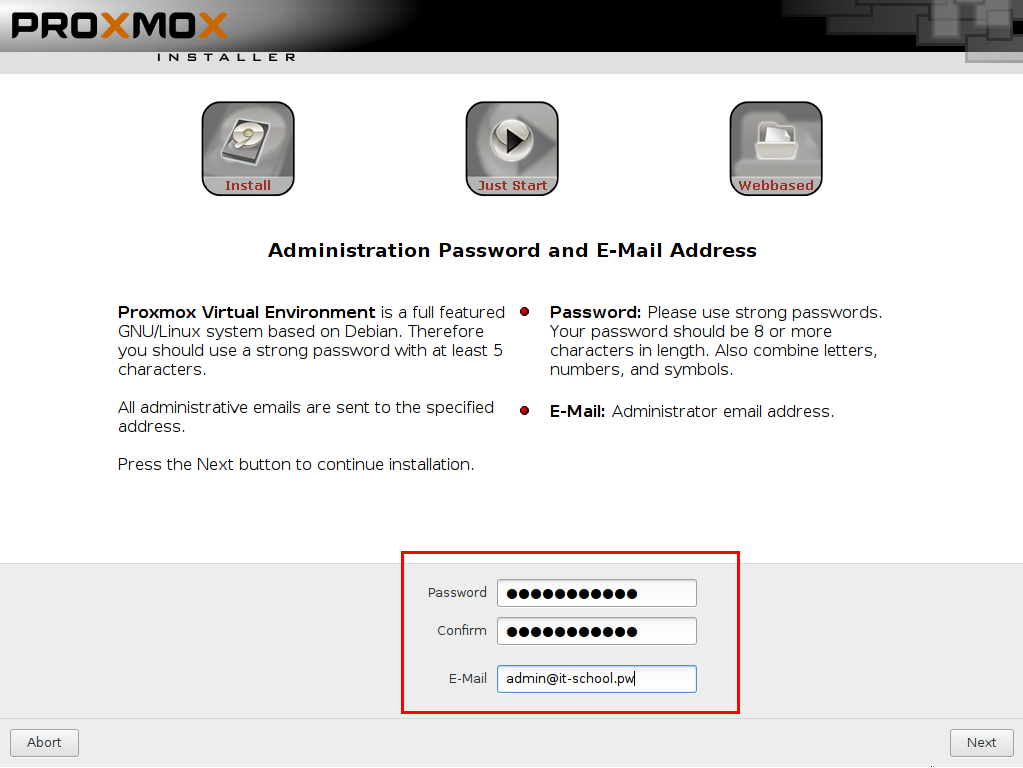

Логин для входа: root Пароль тот, который вы указали при установке.</p>

Настраиваем репозиторий для обновлений

Перво наперво откроем консоль нашего сервера

Нас попросят ввести логин и пароль, вводим те же данные, которые вводили для входа в WEB.</p>

Открываем Enterprise репозиторий…nano /etc/apt/sources.list.d/pve-enterprise.list и комментируем его (добавляем решетку в начало строки)#deb https://enterprise.proxmox.com/debian/pve stretch pve-enterprise

Создаем отдельный лист для репозитория без подпискиtouch /etc/apt/sources.list.d/pve-no-subscription.list Открываем егоnano /etc/apt/sources.list.d/pve-no-subscription.list И добавляем в него репозиторий# proxmox no subscriptions repo deb http://download.proxmox.com/debian/pve stretch pve-no-subscription

Если вы устанавливаете Proxmox другой версии, то версия базовой ОС Debian может отличаться от stretch. В этом случае вам необходимо указать аналогичный тому, что есть в pve-enterprise.list. Также узнать имя дистрибутива можно командой:cat /etc/*-release | grep VERSION_CODENAME Ответ будет примерно такой:VERSION_CODENAME=stretch К примеру уже 6-я версия PVE – buster а не stretch Для обновления списков подаем командуapt update

Если вы хотите сразу проапгрейдить систему, то:apt update && apt upgrade -y apt dist-upgrade reboot

Убираем всплывающее окно о подписке

После входа вы могли заметить сообщение о подписке, которое со временем может надоесть. В принципе его можно оставить если оно вам не мешает. А для тех кому мешает необходимо сделать следующее: Сохраняем резервную копию файла:cp /usr/share/javascript/proxmox-widget-toolkit/proxmoxlib.js /usr/share/javascript/proxmox-widget-toolkit/proxmoxlib.js.bak Подаем команду:sed -i "s/getNoSubKeyHtml:/getNoSubKeyHtml_:/" /usr/share/javascript/proxmox-widget-toolkit/proxmoxlib.js Команда заменяет нужную переменную getNoSubKeyHtml:, на ошибочную getNoSubKeyHtml_: и окно более нам не мешает. Все просто ?

Настраиваем базовую отправку уведомлений на почту

Безусловно мы хотим, чтобы сервер оповещал нас, если вдруг что-то происходит. Например, когда Бэкап виртуальной машины не выполнился. За этот функционал в PVE отвечает сервис Postfix, его и будем настраивать. Для примера я буду использовать придуманный почтовый адрес: ggost@yandex.ru. Вы конечно используете свой! Будем отправлять сообщения от почтового ящика зарегистрированного на Yandex. Для Gmail отличий особых не будет.

Проверяем установлена ли библиотека libsasl2-modulesapt install libsasl2-modules Делаем бекап основного файла конфигурацииcp /etc/postfix/main.cf /etc/postfix/main.cf.bak

Вносим правки в файл. Я привел его к такому виду:# See /usr/share/postfix/main.cf.dist for a commented, more complete version myhostname = pve1.gregory-gost.ru default_transport = smtp smtpd_banner = $myhostname ESMTP $mail_name (Debian/GNU) biff = no # appending .domain is the MUA's job. append_dot_mydomain = no # Uncomment the next line to generate "delayed mail" warnings #delay_warning_time = 4h alias_maps = hash:/etc/aliases alias_database = hash:/etc/aliases mydestination = $myhostname, localhost.$mydomain, localhost relayhost = [smtp.yandex.ru]:587 mynetworks = 127.0.0.0/8 inet_interfaces = loopback-only recipient_delimiter = + header_checks = pcre:/etc/postfix/rewrite_subject smtp_sender_dependent_authentication = yes sender_dependent_relayhost_maps = hash:/etc/postfix/sender_relayhost.hash smtp_sasl_auth_enable = yes smtp_sasl_password_maps = hash:/etc/postfix/sasl_auth.hash smtp_sasl_security_options = noanonymous smtp_use_tls = yes smtp_tls_CAfile = /etc/ssl/certs/ca-certificates.crt smtp_generic_maps = hash:/etc/postfix/generic

Создаем хеш файл авторизации для доступа к почтовому ящикуecho [smtp.yandex.ru]:587 ggost@yandex.ru:yourpassword > /etc/postfix/sasl_auth.hash Создаем хеш файл sender_relayhost (он гарантирует, что мы всегда используем свой почтовый ящик в качестве отправителя)echo ggost@yandex.ru [smtp.yandex.ru]:587 > /etc/postfix/sender_relayhost.hash И скобки [] обязательны!

У Яндекса есть проблема, а именно для успешной отправки письма, Яндекс требует, чтобы адрес отправителя в письме совпадал с адресом для авторизации на сервере. Если это не будет сделано, то мы получим ошибку во время отправки — Sender address rejected: not owned by auth user Чтобы этого избежать мы добавили в конфиг файл /etc/postfix/main.cf пункт smtp_generic_maps = hash:/etc/postfix/generic Происходит это потому, что отправка системных сообщений идет от локального пользователя root. Имя отправителя в письме у меня такое — root@pve1.gregory-gost.ru В данном случае pve1.gregory-gost.ru это локальное имя сервера. Мы его заменим на учетную запись Яндекса. Откройте файл блокнотомnano /etc/postfix/generic Добавьте в файл generic одну строку:root@pve1.gregory-gost.ru ggost@yandex.ru

Шифруем файлы с помощью postmappostmap /etc/postfix/sender_relayhost.hash postmap /etc/postfix/sasl_auth.hash postmap /etc/postfix/generic

Устанавливаем уровень доступа 0600 на файлы sasl_authchmod 0600 /etc/postfix/sasl_auth.*

Дополнительно я ввел формирование специального заголовка для темы. За это отвечает параметр header_checks = pcre:/etc/postfix/rewrite_subject Давайте создадим этот файл:nano /etc/postfix/rewrite_subject Добавляем в него такую строку:/^Subject: (.*)$/ REPLACE Subject: [PVE1]: $1 Это регулярное выражение, которое меняет заголовок письма, начинающийся с Subject. Оно добавляет в начало темы имя сервера с двоеточием — [PVE1]: Вы можете добавлять свой вариант. А $1 это исходное содержание темы, которое будет без изменений оставлено далее, после добавки. Но для того, чтобы это работало, просто создать файл и поправить конфиг мало. Необходимо доустановить специальную библиотеку postfix-pcre Вы ведь помните, как выглядит строка с этой настройкой: pcre:/etc/postfix/rewrite_subject Давайте поставим нужный сервис:apt install postfix-pcre

Перезапускаем Postfixservice postfix restart илиsystemctl restart postfix.service

Пробуем отправить тестовое сообщение адресату:echo "Test mail from proxmox" | mail -s test my-email@gmail.com

Проверяйте почту ?

Проверка работы Postfix:cat /var/log/mail.log | grep postfix

Подключение четырех дисков как ZFS массив RAID-5 (raidz1)

Не забудем и про дополнительные четыре диска, которые в моем случае будут использоваться для хранения медиа файлов (фильмы, сериалы и др.)И да, я знаю про специфику работы с RAID-5 и что к нему есть много вопросов, я решил пойти именно таким путем, вы же можете использовать свои знания и выбрать то, что кажется вам наиболее правильным. Но у ZFS RAID-5 есть одно преимущество, он восстановит потерянные данные, хоть и не целиком. А т.к. у меня там медиа данные, их можно без особого труда скачать снова. Это выгодно отличает его от обычного RAID-5. В итоге я потеряю файл/часть файла, но не потеряю весь массив данных. Для начала проверим, видны ли они в системе, в этом нам поможет команда lsblk:

root@pve1:~# lsblkВ ответ мы увидим, что-то такое…

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT sda 8:0 0 236G 0 disk ├─sda1 8:1 0 1007K 0 part ├─sda2 8:2 0 512M 0 part └─sda3 8:3 0 235.5G 0 part sdb 8:16 0 236G 0 disk ├─sdb1 8:17 0 1007K 0 part ├─sdb2 8:18 0 512M 0 part └─sdb3 8:19 0 235.5G 0 part sdc 8:32 0 2.7T 0 disk sdd 8:48 0 2.7T 0 disk sde 8:64 0 2.7T 0 disk sdf 8:80 0 2.7T 0 diskАктивные диски уже используются и на них можно наблюдать уже логические разделы, это два SSD диска: sda и sdb А вот sdc, sdd, sde и sdf пока не задействованы, давайте это исправим!

Проверим созданный нами ранее RAID-1 из двух SSD

zpool listОтвет

NAME SIZE ALLOC FREE EXPANDSZ FRAG CAP DEDUP HEALTH ALTROOT rpool 234G 8.07G 226G - 0% 0% 1.00x ONLINE -Создадим RAID-5 из нужных нам дисков. Массив назовем rpoolz и пропишем полные пути к дискам (через /dev):

zpool create -f -o ashift=12 rpoolz raidz1 /dev/sdc /dev/sdd /dev/sde /dev/sdfroot@pve1:~# zpool list -vNAME SIZE ALLOC FREE EXPANDSZ FRAG CAP DEDUP HEALTH ALTROOT rpool 234G 8.07G 226G - 0% 0% 1.00x ONLINE - mirror 234G 8.07G 226G - 0% 0% sda3 - - - - - - sdb3 - - - - - - rpoolz 10.9T 2.14T 8.73T - 0% 0% 1.00x ONLINE - raidz1 10.9T 2.14T 8.73T - 0% 0% sdc - - - - - - sdd - - - - - - sde - - - - - - sdf - - - - - -Папка массива в файловой системе доступна по пути, который мы прописали при создании: /rpoolz

В целом этого будет достаточно, но есть еще один момент, это вопрос “Как подключить данный массив как папку для хранения данных?” Для начала необходимо отправиться в раздел Datacenter -> Storage Например я добавил папку, куда сохраняю Backup архивы.

Тут нужно заполнить ID – это имя директории, Directory – это путь в файловой системе к нужной папке. Выбрать тип хранимых данных. При добавлении типа VZDump backup file появится дополнительная настройка, где нудно указать количество хранимых Backup архивов для каждой виртуальной машины. (Настройка архивации виртуальных машин выполняется отдельно!)</p>

Подключение папки массива в контейнерах LXC будем рассматривать уже в отдельных статьях.

Заключение

Ну а дальше… дальше будем ставить контейнеры и виртуалки с сервисами, продолжим с доменных имен в локальной сети с помощью DNS. Следите за обновлениями!

- DNS – доменные имена в локальной сети вместо IP адресов. Домашний Сервер: Часть 3 – Внутренний DNS сервис на BIND9 или свои доменные имена в локальной сети

- Torrent Transmission – качалка торрентов. Домашний Сервер: Часть 4 – Настройка Transmission daemon в контейнере LXC Proxmox-VE

- Plex Mediaserver – домашний медиа сервер. Домашний Сервер: Часть 5 – Установка и настройка Plex Media Server в контейнере LXC Proxmox-VE

- The Dude – мониторинг девайсов в домашней сети.

- Домашний IoT.

- IP телефония.

Делитесь в комментариях, чем пользуетесь вы для организации подобной системы. Готовый NAS, альтернативные системы виртуализации? В общем пишите ?

UPD: 10.11.2019 Добавлен блок с подключением дополнительных дисков, как массива RAID-5

UPD: 20.11.2019 Добавлена заметка по редактированию источников обновления, для разных версий дистрибутивов. Спасибо Константину за подсказку в комментарии.

Если Вам не безразлична судьба блога или Вы просто хотите отблагодарить Автора за его труд, смело переходите на страницу Поддержки, там описана вся информация, по тому, как это сделать. Заранее благодарен вам за данную инициативу!

Если вы нашли ошибку, пожалуйста, выделите фрагмент текста и нажмите Ctrl+Enter.

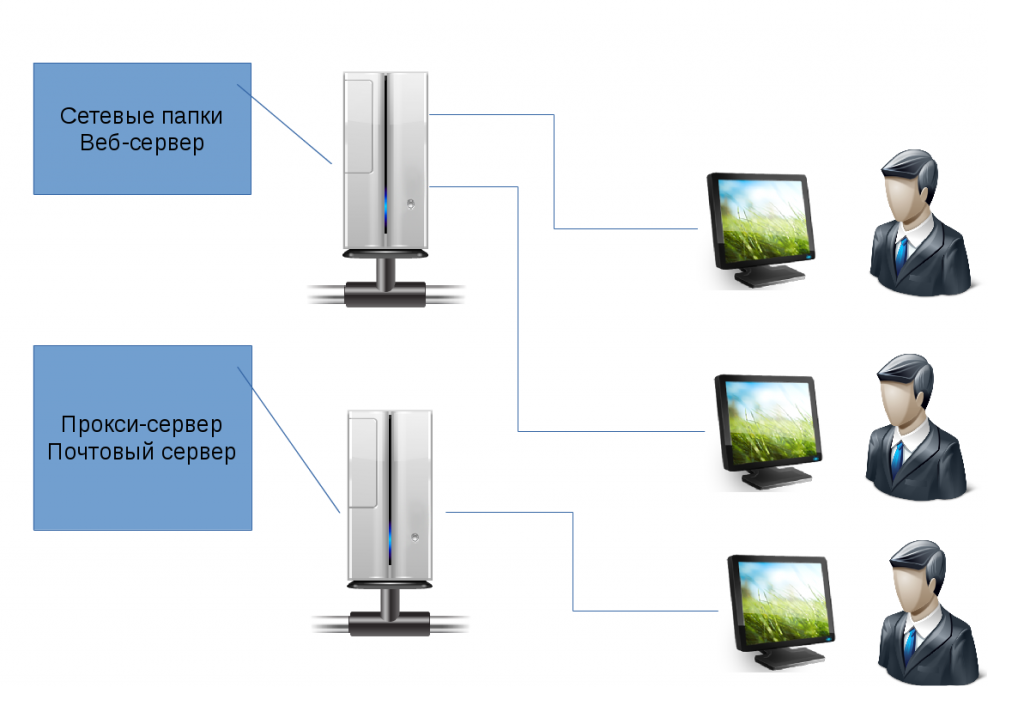

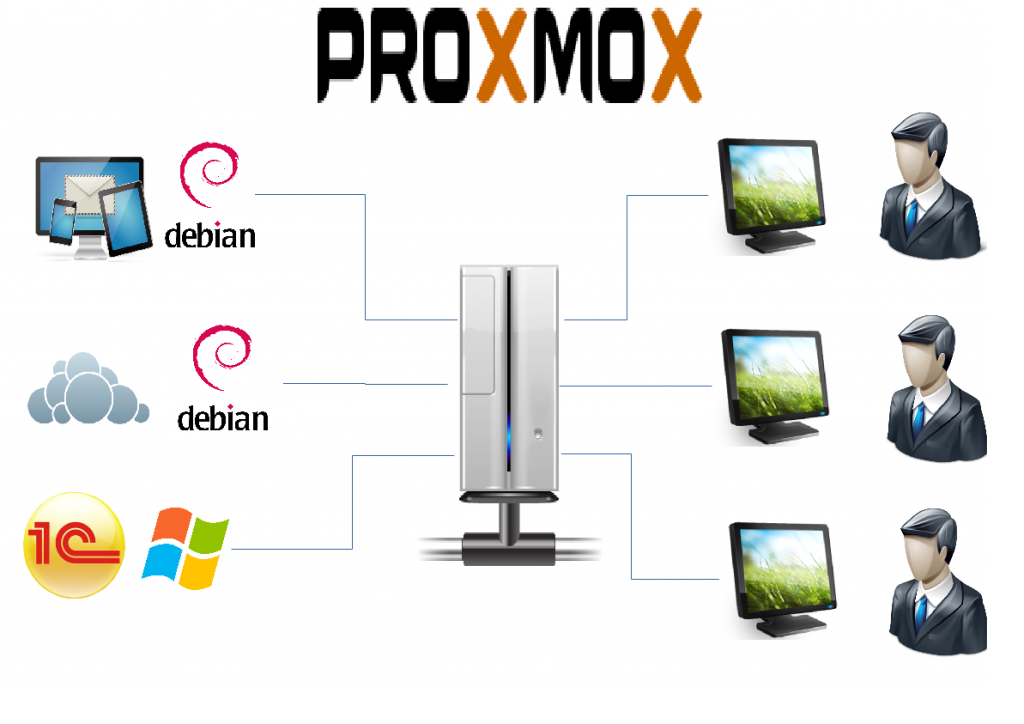

При организации работы серверов в локальной сети предприятия, важную роль играет грамотное использование серверных ресурсов. Одним из важнейших инструментов в оптимизации использования серверных ресурсов является Proxmox VE.

Proxmox Virtual Environment (Proxmox VE) — система виртуализации с открытым исходным кодом, основанная на Debian GNU/Linux. Разрабатывается австрийской фирмой Proxmox Server Solutions GmbH, спонсируемой Internet Foundation Austria. В качестве гипервизоров использует KVM и LXC. Способна выполнять любые поддерживаемые KVM ОС (Linux, *BSD, Windows и другие) с минимальными потерями производительности и Linux без потерь. Управление виртуальными машинами и администрирование самого сервера производятся через веб-интерфейс либо через стандартный интерфейс командной строки Linux.

Оптимизация ресурсов сервера:

Сегодня, практически, любая организация имеет в своем распоряжении один — два сервера, а то и более. Как показывает практика — на сервере установлена операционная система и настроены для работы два-три сервиса (веб-сервер, сетевые папки, почтовый сервер и т. п.). И все это «крутиться в одной операционной системе»:

Однако, если мы захотим реализовать еще какие-то сервисы, то нам понадобиться еще один физический сервер. Но что делать, если лимит физических серверов исчерпан? Естественное решение проблемы — использование систем виртуализации.

Ранее мы рассказывали использовании VirtualBox и веб-интерфейсе управления VirtualBox. Конечно, Proxmox VE, является более профессиональным инструментом в плане управления системой виртуализации.

Ключевые возможности Proxmox VE:

- Простое управление через веб-интерфейс;

- Мониторинг нагрузки в реальном времени;

- Статистика и информативные графики нагрузки сервера виртуализации и каждой виртуальной машины в отдельности — по оперативной памяти, CPU, HDD, сети в разрезе последний час/день/неделя/месяц/год;

- Библиотека установочных образов (в локальном или удаленном хранилище);

- Подключение к «физической» консоли гостевых систем непосредственно из браузера (по VNC и посредством SPICE-клиента);

- Объединение серверов в кластер с возможностью живой миграции виртуальных машин (без остановки гостевой системы);

- Быстрое развертывание гостевых систем из шаблонов;

- Сохранение образа состояния виртуальной машины (snapshot), формирование дерева состояний и возможность отката на любую из точек

- Автоматическое резервное копирование виртуальных машин.

- С сайта разработчиков можно загрузить готовые шаблоны (как дистрибутивы общего назначения, так и настроенные под конкретную задачу, например запуск MediaWiki, Drupal или WordPress).

Подготовка к установке:

1. После того, как мы решили использовать систему виртуализации Proxmox VE на серверах организации, необходимо подобрать сервер, удовлетворяющий минимальным параметрам, необходимым для работы системы:

- CPU: 64bit (Intel EMT64 or AMD64), поддержка Intel VT/AMD-V CPU/Mainboard (для использования KVM Full Virtualization);

- Минимум 1 Гб ОЗУ;

- Жёсткий диск;

- Сетевая карта.

2. Скачиваем образ системы с официального сайта: https://www.proxmox.com/en/downloads, записываем на диск или флеш-накопитель. И приступаем к установке.

Установка:

1. Выбираем пункт «Install Proxmox VE»:

2. Соглашаемся с лицензионным соглашением:

3. Указываем жестки диск, который будет использоваться системой:

4. Выбираем часовой пояс:

5. Указываем пароль и e-mail администратора системы:

6. Задаем параметры сетевого подключения:

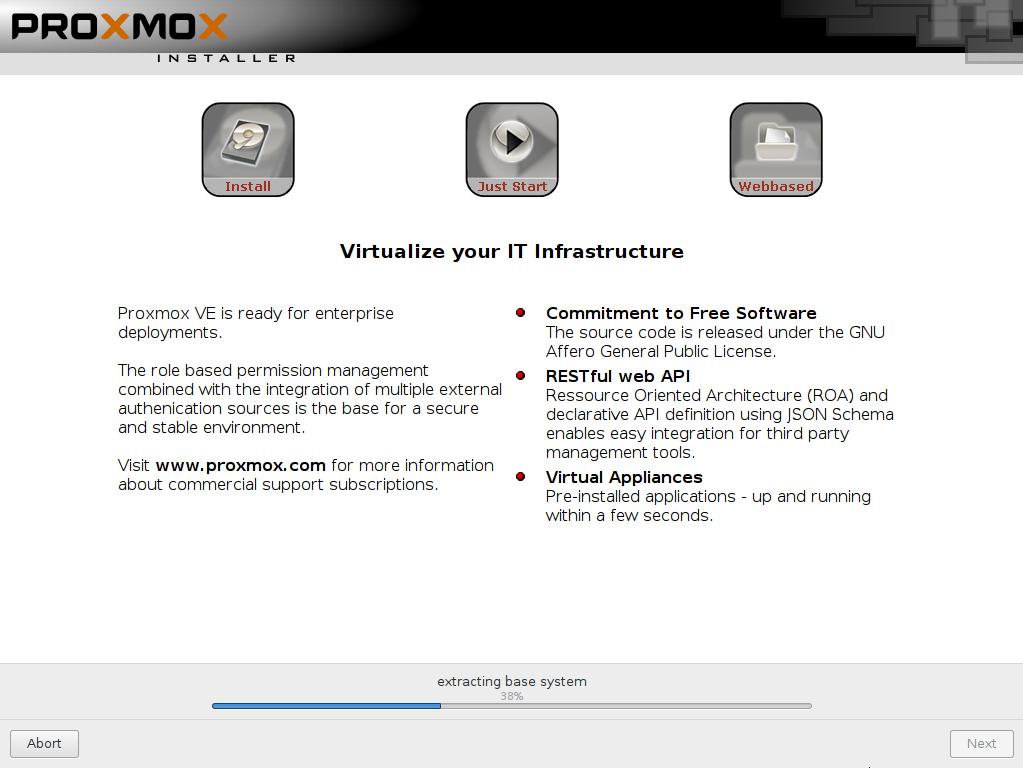

7. Наблюдаем процесс копирования и инсталляции пакетов:

8. Перезагружаем систему:

Начало работы:

1. Запускаем браузер и переходим по адресу: https://[ip — сервера]:8006, выбираем язык панели управления Russian, пользователь root, пароль.

2. Теперь мы можем создавать виртуальные машины, распределять нагрузку между системами, производить бэкапирование образов систем:

Пример работы:

</h5>

Источник:

Похожие записи:

Установка и настройка Remmina в Debian JessieVirtualBox — пробрасываем портыСервер контентной фильтрации на базе Debian 9 «Stretch»Apache2 — настройка для работы с несколькими сайтами в DebianИспользуемые источники:

- https://interface31.ru/tech_it/2019/09/ustanovka-i-nastroyka-proxmox-ve-60.html

- https://gregory-gost.ru/domashnij-server-chast-2-ustanovka-sistemy-virtualizaczii-proxmox/

- https://it-school.pw/proxmox-ustanovka-i-nastrojka/

Postfix: настройка, установка. Почтовый сервер Postfix

Postfix: настройка, установка. Почтовый сервер Postfix Почтовый сервер Postfix

Почтовый сервер Postfix

Установка OpenVPN в Ubuntu

Установка OpenVPN в Ubuntu

Домашний сервер. Часть 2. FTP, Samba и rTorrent

Домашний сервер. Часть 2. FTP, Samba и rTorrent Блог о системном администрировании. Статьи о Linux, Windows, СХД NetApp и виртуализации.

Блог о системном администрировании. Статьи о Linux, Windows, СХД NetApp и виртуализации. Сервер FTP

Сервер FTP Установка и настройка прокси-сервера Squid

Установка и настройка прокси-сервера Squid