Содержание

VMWare

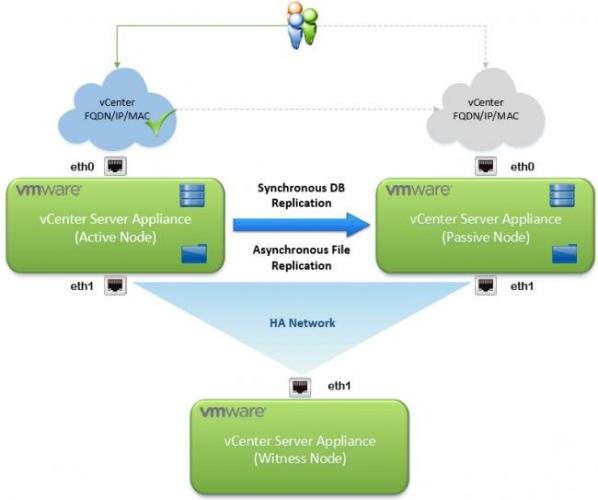

В vSphere 6.5 появилась встроенная возможность организации отказоустойчивого сервера vCenter High Availability (VCHA). Архитектурно решение VCHA реализации за счет создания пассивной копии сервера vCenter, которая выполняется на другом узле ESXi, чем обеспечивается высокая доступность экземпляра vCenter при аппаратных или программных проблемах.

Содержание:Архитектура высокой доступности сервера VMWare vCenter 6.5</li>Настройка высокой доступности vCenter</li></ul>

Архитектура высокой доступности сервера VMWare vCenter 6.5

Архитектура отказоустойчивого VCHA состоит из 3 узлов: активного, пассивного экземпляра vCenter Server Appliance и хоста-свидетеля. Активный экземпляр vCenter Appliance имеет два сетевых интерфейса: стандартный интерфейс управления (eth0) и специальный интерфейс HA (eth1). VCHA реплицирует данные с активной ноды на пассивную по HA сети. База данных активной копии vCenter реплицируется в синхронном режиме, а файловая система – в асинхронном. У пассивной копии также 2 сетевых интерфейса, однако основной его интерфейс eth0 с теми же FQDN, IP и MAC неактивен. Интерфейс активируется в случае сбоя основного экземпляра сервера vCenter. Свидетель является последним элементом архитектуры VCHA. Он используется для предоставления ресурса-кворума, информируя кластер о том, какой из узлов является активным в текущий момент времени. В нормальном режиме работы все три компонента кластера должны быть доступны.

При сбое, на пассивной ноде активируется интерфейса eth0. С помощью механизма Gratuitous ARP выполняется оповещение устройств в широковещательном домене о появлении новой привязки IP и MAC. Если оригинальная нода после сбоя опять появляется в сети, она снова становится активной и репликация восстанавливается. В том случае, если он полностью утрачена, ее можно удалить из конфигурации и пересоздать кластер VCHA.

Что потребуется для организации высокодоступного сервера vCenter

- vCenter Server Appliance версии 6.5

- Лицензия vCenter Standard

- Размер развертывания vCSA: Small, Medium или Large (но не tiny)

- Встроенный или внешний Platform Services Controller (PSC)

- ESXi 5.5 и выше

- Рекомендуется использовать как минимум 3 хоста

- Сеть vCenter HA

- Отдельная HA сеть, отделенная от сети управления

- Сетевая задержка между двумя узлами не более 10мс

- Статические IP адреса на нодах

Настройка высокой доступности vCenter

Настройку HA для vCenter следует начать с создания новой отдельной HA сети. В нашем примере мы добавим группу портов HA в существующий виртуальный коммутатор. Т.к. мы используем стандартные виртуальные коммутаторы, группа портов HA добавится на 3 хостах.

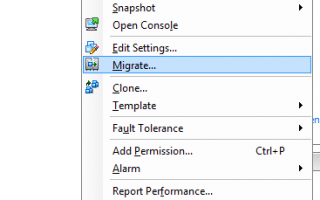

После создания сети, щелкните ПКМ по серверу vCenter Server в разделе навигации клиента vSphere Web Client. В меню выберите vCenter HA Settings.

В меню vCenter HA нажмите на кнопку Configure в правом верхнем углу.

Есть два варианта настройка HA.

- Basic – автоматическое клонирование сервера и настройка всех трех узлов

- Advanced – настраиваемый вариант развёртывания, клонирование сервера и настройка узлов кластера выполняется в ручном режиме.

Мы остановился на самом простом — автоматическом варианте Basic.

Укажем IP адрес и подсеть для HA интерфейса на активной ноде. В качестве сети нужно выбрать созданную ранее выделенную сеть HA.

Укажите IP адрес пассивной (Passive) ноды и свидетеля (Witness).

Проверьте предложенный вариант развертывания. Внесите необходимые изменения, выбрав хост, кластер и VMFS хранилище.

Если все ОК, нажмите кнопку Finish для начала развертывания.

Запустите процесс клонирования и автоматической настройки трех узлов. Процесс выполнения развертывания можно отслеживать в разделе Recent Tasks.

После завершения развертывания в иерархии vCenter появятся два новых узла. Как вы видите, для пассивной копии vCenter добавлена постфикс –peer , а для свидетеля –witness.

Главная→Virtualization, Без рубрики→Конфигурация отказоустойчивого кластера VMware vSphere —> —>

Один из часто задаваемых вопросов – как построить отказоустойчивый кластер vSphere? На самом деле это очень просто, компания VMware прилагает огромные усилия к тому, чтобы конфигурирование ее продуктов и управление ими не занимали слишком много времени и сил у администраторов, и не требовалось запоминать трехэтажные комбинации команд. В частности создание кластерной файловой системы занимает буквально два-три клика мышкой, а дальше она автоматически подключается ко всем хостам, у которых есть доступ к соответствующему дисковому массиву.

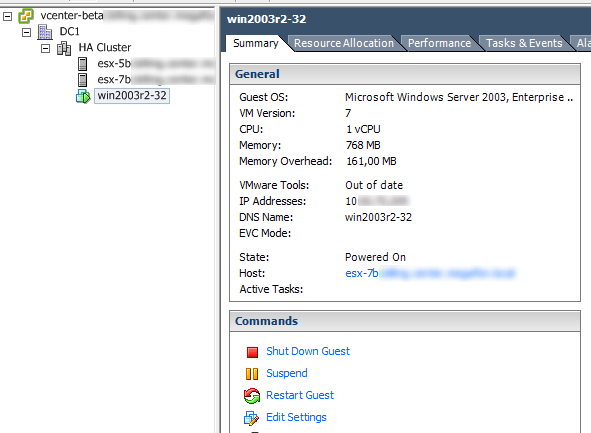

Предполагается, что уже установлен vCenter Server и 2 ESX сервера, заданы IP адреса управляющих консолей и более ничего. Подключаемся к vCenter при помощи vSphere Client (его можно скачать с https://).

Корневым элементом инфраструктуры vSphere является датацентр, поскольку единственный vCenter может управлять до 300 ESX хостов, разбросанных географически. Создадим новый датацентр DC1 (подробности пропущу, это тривиально и не требует никаких настроек). В итоге у нас должна получиться примерно такая картинка:

Кластер с точки зрения VMware – это логическое объединение нескольких ESX хостов, причем кластер может быть не высокой доступности, и даже не иметь общего хранилища. Зачем такие кластеры? Например, для удобства управления – можно объединить несколько хостов в кластер и выдавать разрешения сразу на кластер, а не на каждый хост в отдельности.

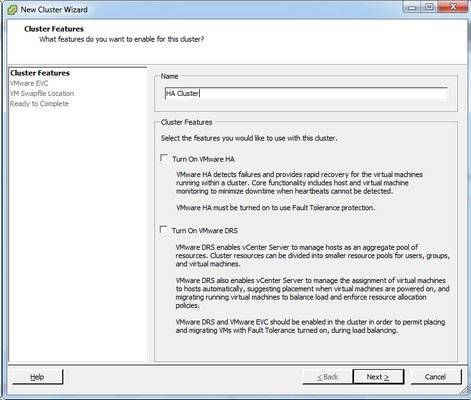

Для начала создадим кластер без всего, пустой и одинокий.

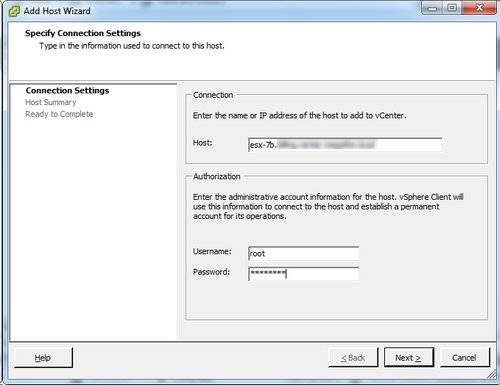

А теперь добавим в него пару ESX хостов: esx-5b и esx-7b. Для этого достаточно просто кликнуть правой кнопкой по кластеру и сказать “Add Host”.

Обращаю ваше внимание, что в VI3 кластеры были очень чувствительны к DNS, и хотя в vSphere 4 чувствительность несколько снизилась, в любом случае обеспечение высокой доступности DNS является первостепенной задачей. В маленьких инфраструктурах допустимо вручную править /etc/hosts, однако я не рекомендую этого делать и вообще без абсолютной необходимости что-то править в конфигах сервис-консоли вручную. Всегда есть вероятность при переезде забыть что и где было исправлено когда-то, и соотв. потратить уйму времени и сил, пытаясь понять почему все работает как-то странно.

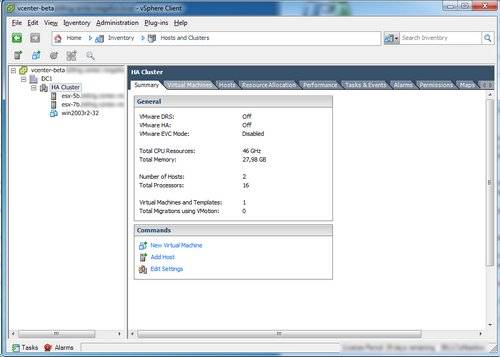

Итак, у нас теперь есть небольшой кластер:

Кластер высокой доступности (HA – high availability) обеспечивает автоматический перезапуск ВМ в случае смерти одного из хостов на оставшихся в живых. Для ВМ это выглядит как выключение питания и включение через 15 секунд (тайм-аут по умолчанию). Подробнее о механизме работы HA можно прочитать здесь.

Кластер у нас есть, но как сделать из него кластер высокой доступности? Прежде всего нам необходимо общее хранилище, доступ к которому имеют все хосты кластера – у нас на каждом хосте пока только локальные диски.

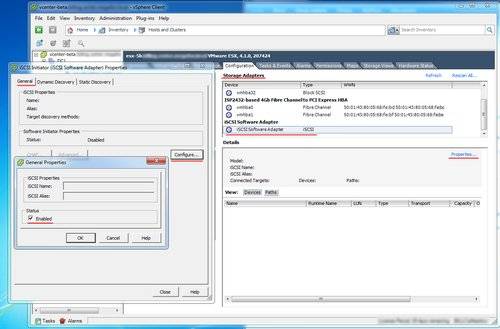

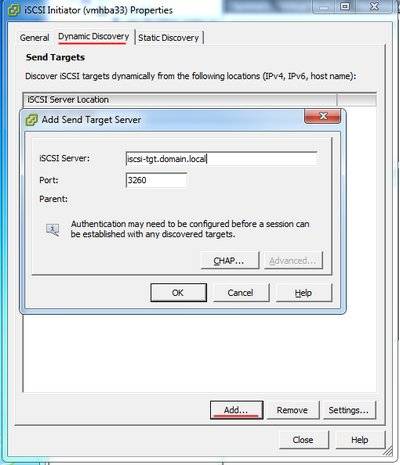

Общее разделяемое хранилище мы будем строить на iSCSI (как построить его из подручных материалов – здесь), с использованием программного инициатора. Обратим свое внимание на настройку сети ESX хоста.

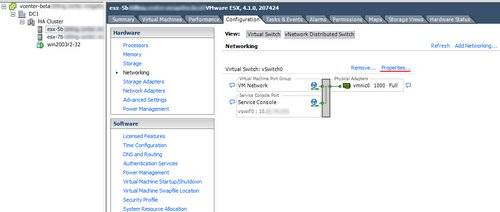

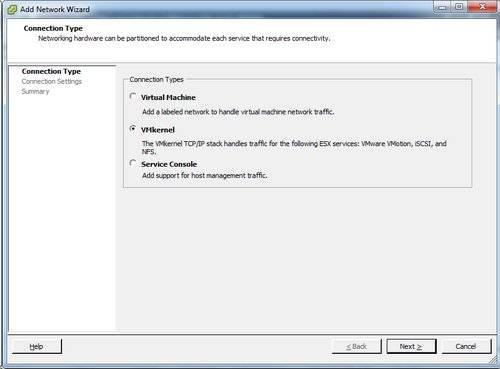

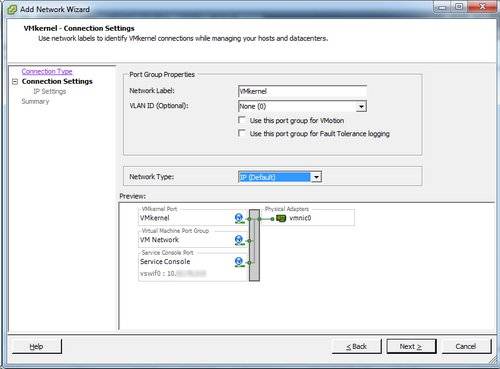

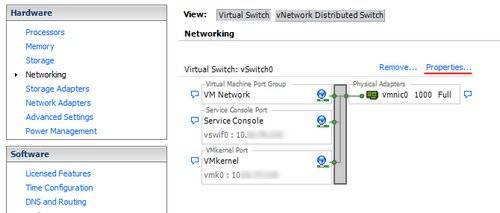

Очень важно понять особенность работы ESX с сетью. Прежде всего забудьте, что у сетевой карты (порта) может быть IP адрес, его здесь нет. В каждом ESX есть как минимум один виртуальный L2 коммутатор, который создается по умолчанию и называется vSwitch0. Все физические сетевые карты используются только одним способом – служат окном во внешнюю сеть, аплинком. С другой стороны vSwitch’а существуют портгруппы, которые бывают трех типов: Service Console (только для ESX), VMkernel и Virtual Machine Network. Виртуальные машины подключаются к виртуальной сети не напрямую, а в портгруппу типа Virtual Machine Network, причем конкретной портгруппе может быть присвоен VLAN ID, и в этом случае ESX будет разбирать трафик по разным портгруппам в соответствии с VLAN’ами.

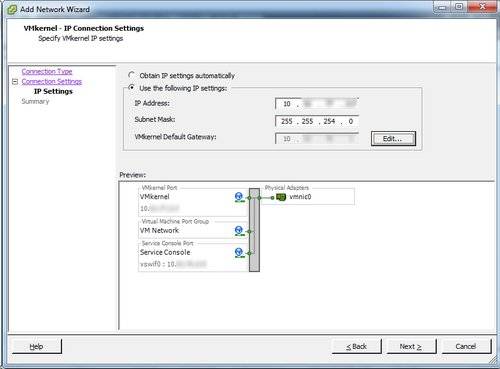

Для работы IP Storage (NFS и программного iSCSI) нам требуется специализированная портгруппа типа VMkernel – по сути это специализированный виртуальный интерфейс, который как раз имеет свой собственный IP.

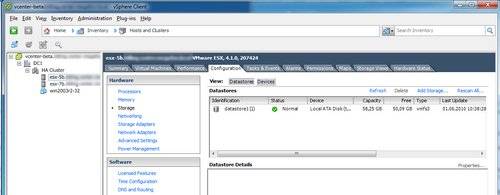

VMkernel сконфигурирован, переходим к подключению iSCSI хранилища.

Подключаем дисковое хранилище ко всем хостам кластера.

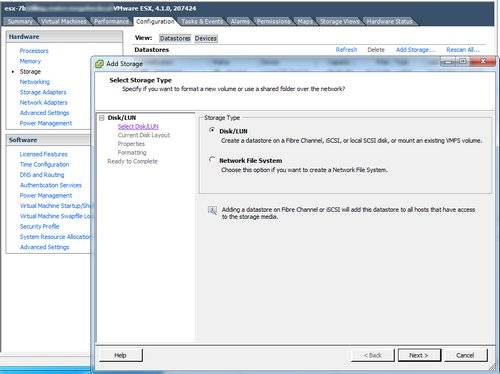

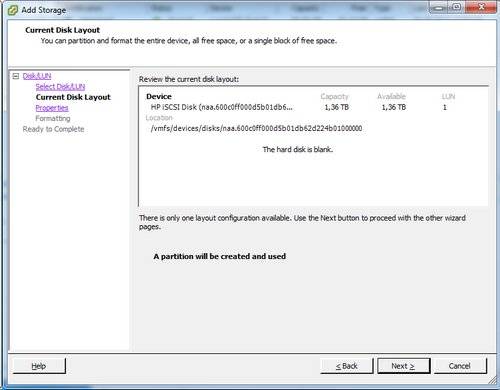

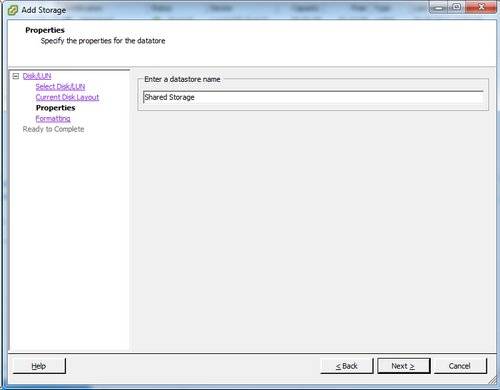

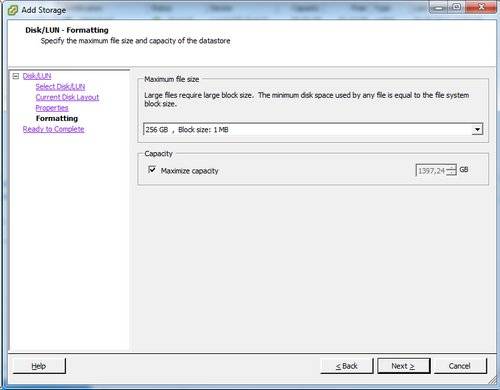

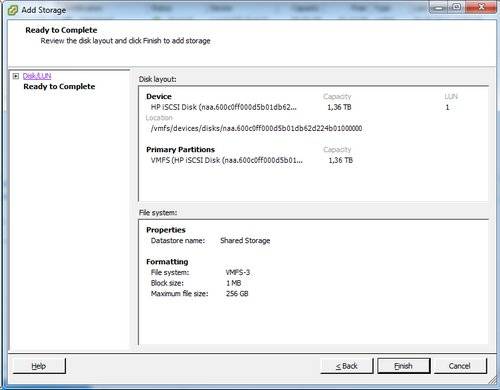

И создаем датастор с VMFS на iSCSI LUN.

Нажимаем Finish, ждем чуть-чуть, пока будет создана файловая система. Все хосты автоматически пересканируют свои HBA и подключат новый дастастор. В силу архитектуры VMFS для совместного использования несколькими хостами LUN должен быть презентован всем хостам под одним и тем же LUN ID.

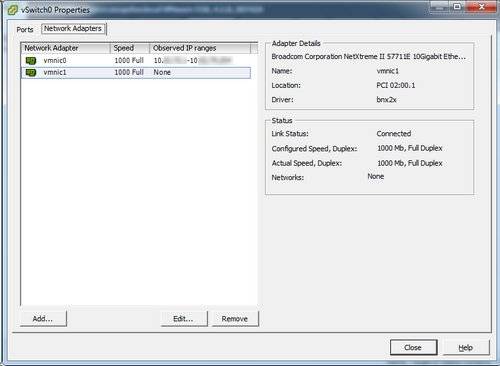

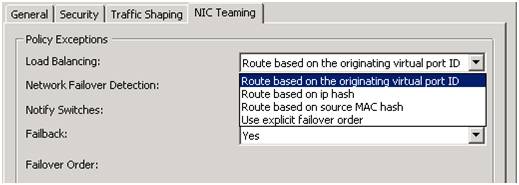

Датастор для машин с требованием высокой доступности уже есть, теперь надо позаботиться о высокой доступности heartbeat сети, в случае ESX это портгруппа Service Console. На сервере установлена двухпортовая сетвая карта, поэтому будем использовать второй порт в качестве резервного. Заходим в свойства vSwitch0:

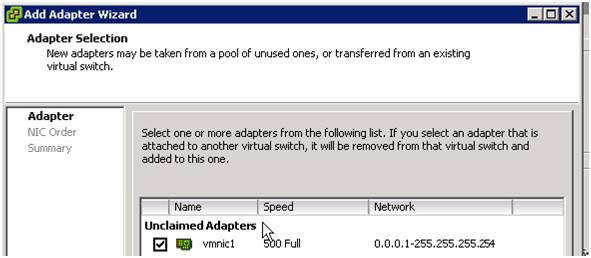

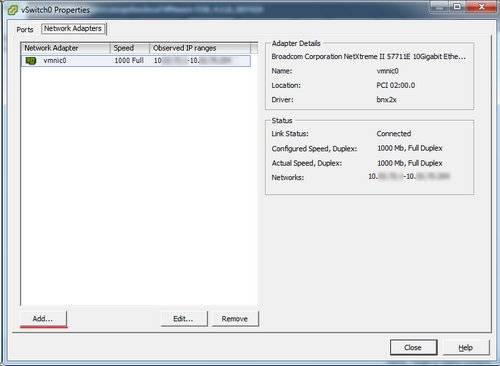

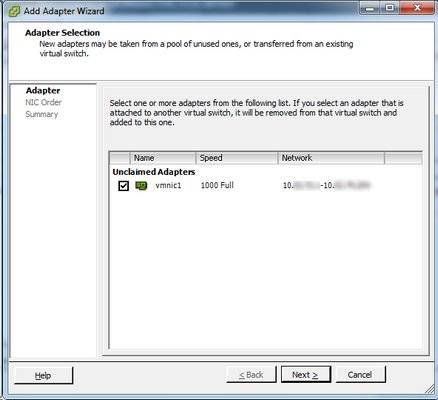

Как видно, аплинк на коммутаторе один, поэтому сначала добавим второй порт еще одним аплинком. У ESX есть одна очень приятная особенность – при выборе сетевого интерфейса мы видим трафик из какой сети пролетает мимо интерфейса. Это очень удобно, если у нас много сетевых интерфейсов и VLAN’ов, помогает не запутаться какой именно интерфейс нам нужен. Тем не менее, это не гарантированная информация, и не надо паниковать, если интерфейс видит не совсем то, что вы ожидали.

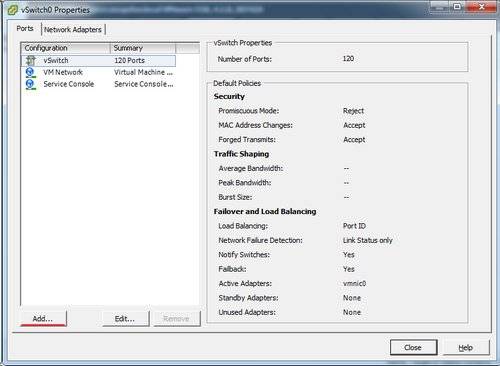

В свойствах vSwitch можно задать политику использования интерфейсов как на уровне vSwitch целиком, так и для каждой из портгрупп, чем мы и воспользуемся. vSwitch будет работать одновременно с двумя интерфейсами.

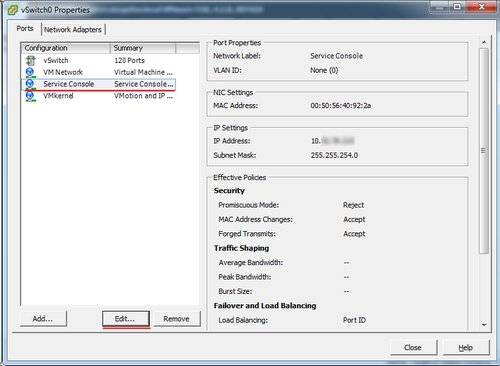

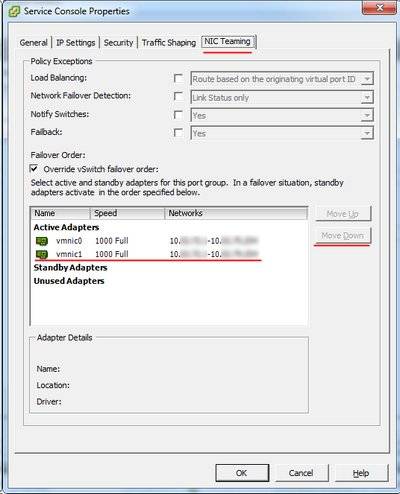

А вот Service Console получит доступ ко второму порту только если основной для нее, vmnic0, потеряет линк.

Включаем “Override vSwitch failover order”, выбираем vmnic1 и перемещаем его в Standby.

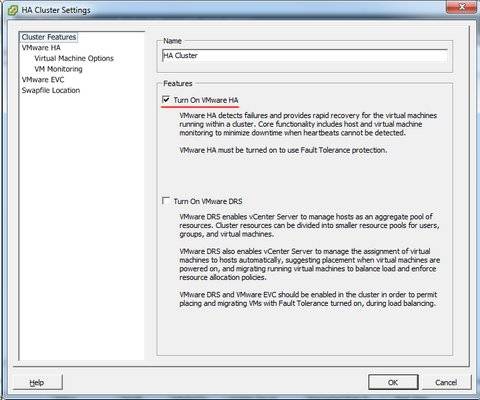

На этом предварительная конфигурация закончена и мы можем включить режим HA для кластера. Все, что для этого нужно сделать – поставить одну галочку.

В свойствах кластера:

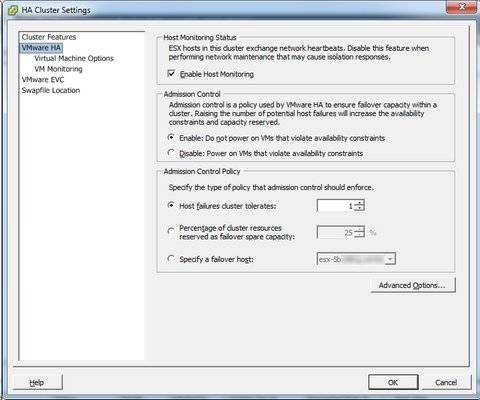

Настройки HA оставляем по умолчанию.

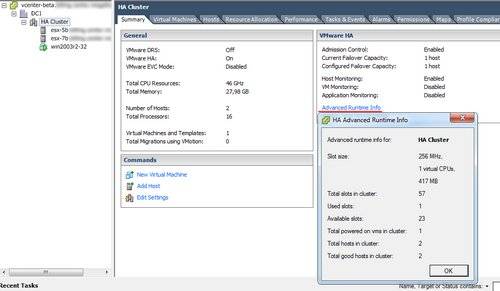

Создаем первую виртуальную машину в кластере, причем обязательно на разделяемом хранилище, и включаем ее. “HA Advanced Runtime info” покажет нам использование ресурсов (подробное описание – здесь).

***

Строго говоря, следующий материал по конфигурированию VMotion не имеет прямого отношения к HA-кластеру, и приводится лишь для демонстрации легкости конфигурирования.

***

А что нужно сделать, чтобы начала работать живая миграция, VMotion?

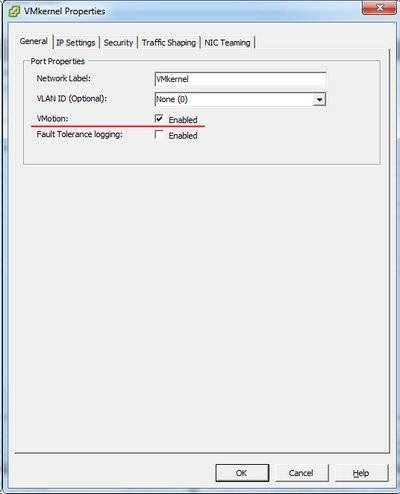

Для этого придется совершить поистине титаническое усилие: поставить еще одну галочку. На этот раз в свойствах портгруппы VMkernel – она используется как для IP Storage, так и для VMotion (а в случае ESXi еще и вместо Service Console).

Включить VMotion на интерфейсе VMkernel необходимо, разумеется, на обоих хостах.

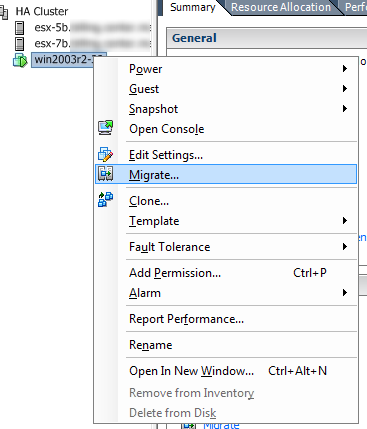

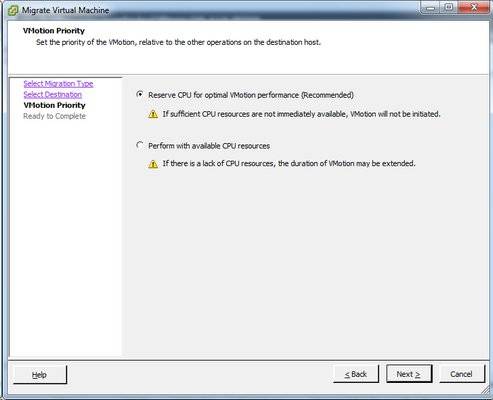

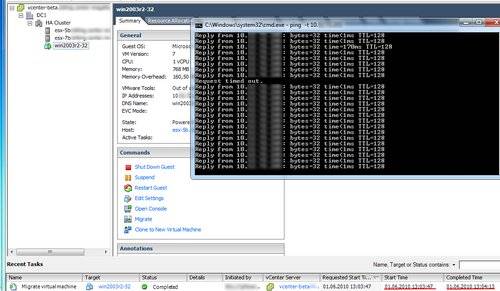

Совершим первую живую миграцию ВМ.

Впрочем, можно и просто перетащить мышкой ВМ на хост ?

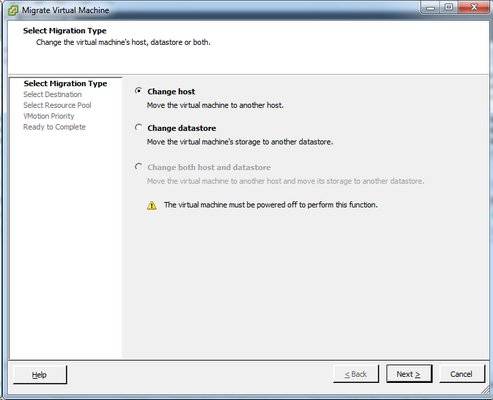

В меню миграции есть так же и дисковая миграция – в частности Storage VMotion, прозрачный переезд ВМ на другой датастор без выключения ВМ, но нас интересует смена хоста.

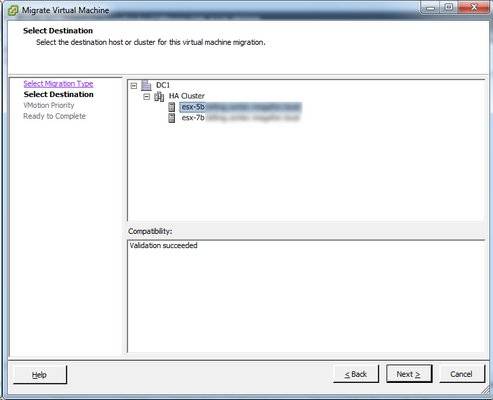

vСenter автоматически проверит все условия, и выдаст результат – можем ли мигрировать машину, и если нет, то почему.

Потерян один пинг, но сессии не разорвались, и работа продолжилась уже на другом хосте.

Антон Жбанков

http://blog.vadmin.ru

- Рубрика:Virtualization,Без рубрики

- Автор: Anton Zhbankov

- Дата: Tuesday 01 Jun 2010

Практическим применением знаний о работе с массивами EVA и iLO в серверах ProLiant, которые вы получили чуть раньше, может стать развертывание высокодоступного кластера на vSphere. Кластер может использоваться для предприятий среднего и крупного размера, чтобы уменьшить время внеплановых простоев. Поскольку для бизнеса важны такие параметры как доступность его сервиса или услуги клиенту в режиме 24×7, то такое решение основывается на кластере высокой доступности. В кластер всегда входят как минимум 2 сервера. В нашем решении серверы под управлением VMware отслеживают состояние друг друга, при этом в каждый момент времени ведущим будет только один из них, на нем будет разворачиваться виртальная машина с нашим бизнес-приложением. В случае отказа ведущего сервера его роль автоматически принимает второй, при этом для заказчика доступ к бизнес-приложению практически не прерывается.

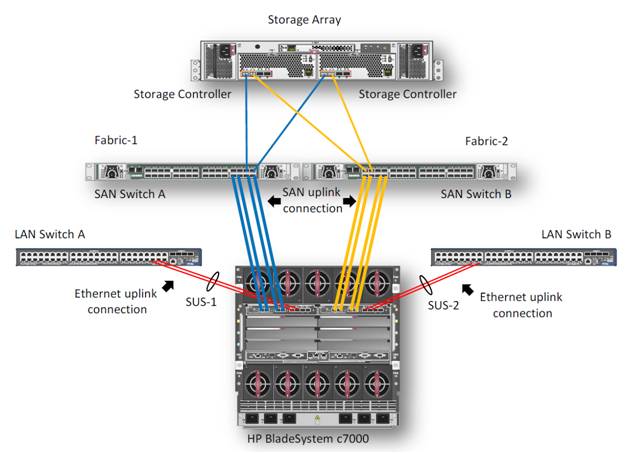

1. Описание задачи

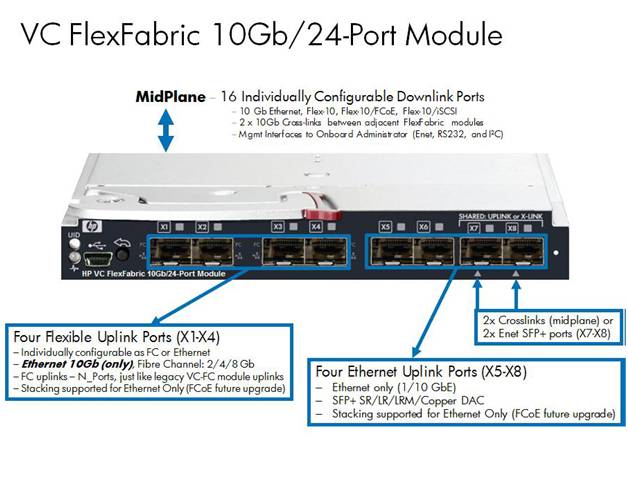

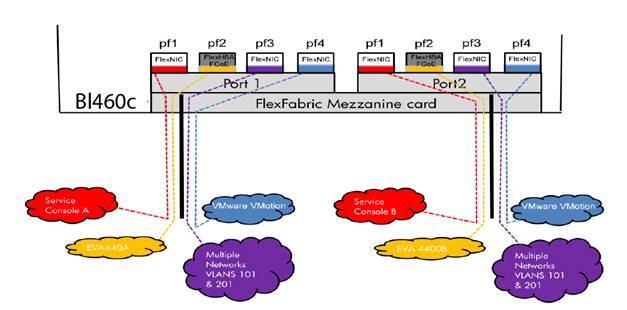

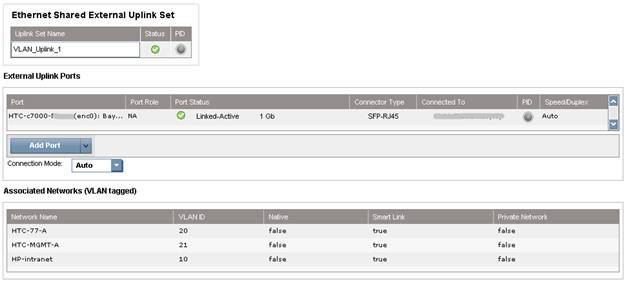

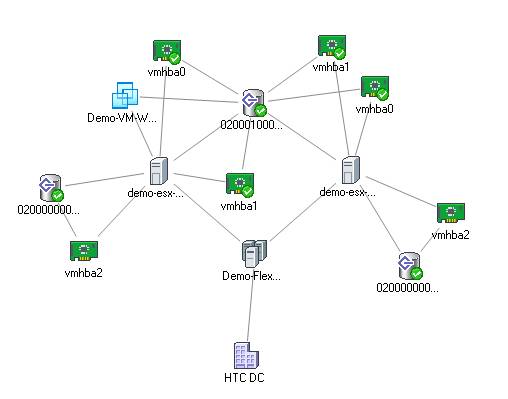

В данном примере мы опишем процесс создания высокодоступного кластера VMware на блейд-серверах BL460c G7. Оборудование состоит из блейд-корзины HP c7000 и двух блейд-серверов BL460c G7, где скофигурирован VMware HA(High Available)-кластер. В демо-центре HP в Москве сейчас доступны только модели блейд-серверов G7, но на основе описанного примера можно собрать кластер и на новых блейд-серверах Gen8. Конфигурирование, в целом, не будет различаться. Система хранения – HP EVA 4400. Для Ethernet и Fibre Channel подключений в корзине c7000 установлены 2 модуля HP Virtual Connect Flex Fabric в отсеках 1 и 2.

2. Описание компонентов

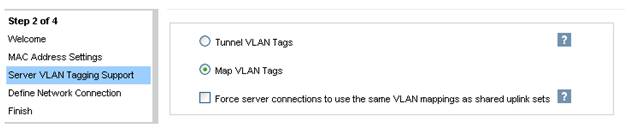

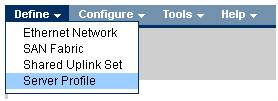

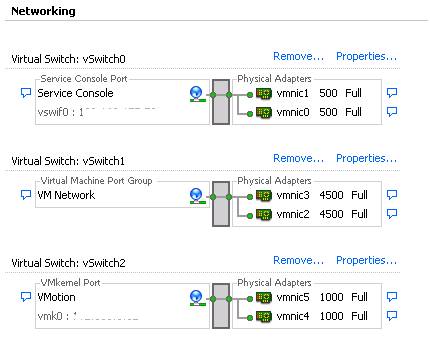

3. Настройка профилей в Virtual Connect Manager

4. Настройка кластера VMware

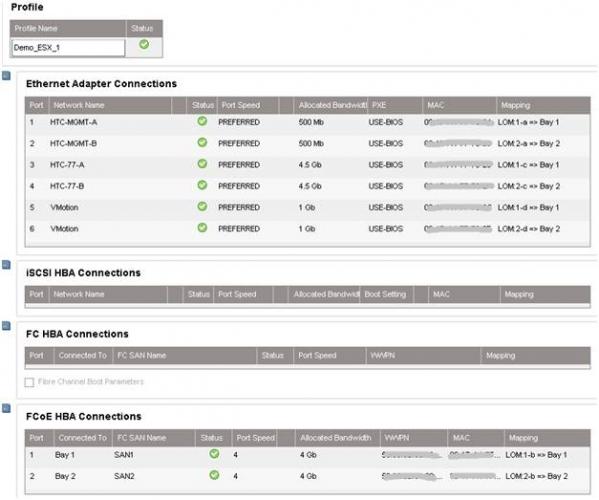

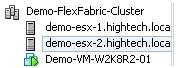

На этом настройки корзины завершены. Далее происходит удаленное подключение к самим блейдам и разворачивание VMware ESX 5.0, пример удаленной установки ОС на серверы ProLiant через iLO уже был описан. В нашем случае вместо Windows в выпадающем меню установщика выбирается VMware и указывается путь к дистрибутиву. После установки сервер перезагружается и можно приступать к настройке виртуальных машин. Для этого подключаемся к серверу ESX. Заходим в раздел Configuration, создаем 6 vmnics на каждый хост, как и в модуле Virtual Connect: Service Console (vSwitch0), VM Network (vSwitch1), vMotion (vSwitch2). Таким образом мы получаем отказоустойчивую конфигурацию, где каждой сети соответствую 2 vmnics.

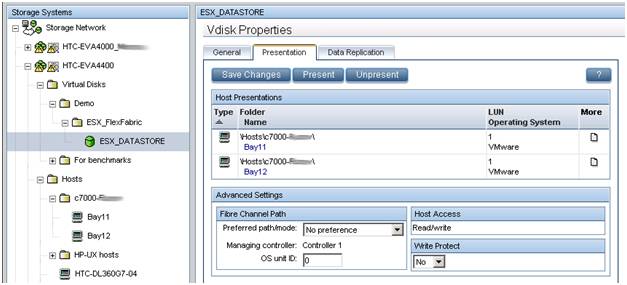

5. Настройка дискового массива EVA 4400

В предыдущем обзоре было рассказано как работать с интерфейсом управления дисковыми массивами EVA — Command View.

6. Внедрение VMware HA и VMware vMotion

HP Virtual Connect в сочетании с VMware vMotion дает тот же уровень избыточности, как при использовании двух модулей VC-FC и двух модулей VC-Eth, за исключением того, что только 2 модуля HP FlexFabric необходимы. HP Virtual Connect FlexFabric дает возможность организовать отказоустойчивые пути к общему LUN и отказоустойчивого объединения сетевых интерфейсов (NIC Teaming) для работы в сети. Все настройки VMware vSphere отвечают Best Practices описанным в документе. Была проведена проверка на доступность кластера. На одном из хостов была развернута виртуальная машина Windows 2008 Server R2.

- https://vmblog.ru/nastrojka-vysokoj-dostupnosti-ha-dlya-vmware-vcenter-6-5/

- http://itband.ru/2010/06/vsphere-ha-cluste/

- https://habr.com/company/hp/blog/145859/

Что нужно настроить в mySQL сразу после установки?

Что нужно настроить в mySQL сразу после установки? Настройка сервера Minecraft на CentOS

Настройка сервера Minecraft на CentOS

CUCM и Region, что и для чего?

CUCM и Region, что и для чего?

Настройка клиентов WSUS с помощью групповых политик

Настройка клиентов WSUS с помощью групповых политик Прокси соединение: что за зверь и зачем оно тебе

Прокси соединение: что за зверь и зачем оно тебе Как установить и настроить OpenVPN клиент

Как установить и настроить OpenVPN клиент Как создать виртуального оператора сотовой сети (MVNO)

Как создать виртуального оператора сотовой сети (MVNO)